|

Опрос

|

реклама

Быстрый переход

Microsoft и OpenAI построят ИИ-суперкомпьютер Stargate за $100 миллиардов

30.03.2024 [12:19],

Павел Котов

Microsoft и OpenAI разрабатывают проект Центра обработки данных нового поколения с бюджетом $100 млрд и суперкомпьютером для искусственного интеллекта. Объекту присвоено кодовое наименование Stargate, а начало работы над ним намечено на 2028 год.

Источник изображения: Colin Behrens / pixabay.com О масштабном совместном проекте Microsoft и OpenAI сообщил ресурс The Information и «три человека, которые участвовали в частных беседах по поводу этого предложения». Один из источников лично обсуждал вопрос с главой OpenAI Сэмом Альтманом (Sam Altman) и ознакомился с предварительными сметами расходов Microsoft: строительство нового ЦОД и ИИ-суперкомпьютера обойдётся в $100 млрд, то есть в сто раз дороже ряда наиболее крупных и мощных ЦОД на планете. План по разработке и строительству суперкомпьютеров Microsoft и OpenAI включает пять этапов — сейчас компании находятся в середине третьего, а значительная часть бюджетов двух последующих будет направлена на приобретение ИИ-ускорителей в необходимых объёмах. Четвёртый этап, о котором будет объявлено в 2026 году, включает создание суперкомпьютера для OpenAI. Пятый предполагает строительство крупнейшего на рынке суперкомпьютера Stargate с миллионами чипов для ИИ — его планируют завершить к 2030 году. В действительности расходы на объект могут превысить $115 млрд, передаёт The Information, и это втрое превышает расходы Microsoft на серверы, здания и другое оборудование в 2023 году. «Мы всегда планируем новое поколение инфраструктурных инноваций, чтобы продолжать раздвигать границы возможностей ИИ», — прокомментировал проект представитель Microsoft агентству Reuters. В конце минувшего года Microsoft представила два собственных ИИ-чипа, а Nvidia недавно анонсировала самый мощный ускоритель Blackwell B200 — он, по словам главы компании Дженсена Хуанга (Jensen Huang), обойдётся от от $30 000 до $40 000. AMD наняла бывшего директора Национальной лаборатории Ок-Ридж для продвижения ИИ-суперкомпьютеров на Instinct и EPYC

05.03.2024 [12:06],

Алексей Разин

На протяжении многих лет заказчиком строительства самых производительных суперкомпьютерных систем в США являлась Национальная лаборатория Ок-Ридж, относящаяся к Министерству энергетики США. Её бывший директор Томас Закария (Thomas Zacharia) теперь займёт пост старшего вице-президента AMD, помогая компании развивать партнёрские отношения в сфере высокопроизводительных вычислений.

Источник изображения: AMD Об этом назначении компания AMD сообщила на текущей неделе. В пресс-релизе отдельно подчёркивается наличие у Томаса Закарии 35-летнего опыта работы в данном научно-исследовательском учреждении, который может быть полезен AMD для продвижения своих систем искусственного интеллекта на рынках разных стран. Этого ветерана отрасли компания собирается привлекать для развития частно-государственного партнёрства в сфере создания систем искусственного интеллекта. Полное наименование должности Закарии подразумевает курирование стратегических партнёрских проектов и публичной политики в данной сфере. Компания хочет сотрудничать с государственными структурами разных стран, некоммерческими организациями и компаниями, чтобы предлагать им адаптированные под нужды конкретных клиентов серверные системы, предназначенные для работы с искусственным интеллектом. Томас Закария взаимодействовал с AMD на этапе строительства суперкомпьютера Frontier, и уже тогда получил представление о технологических возможностях компании и потенциале команды управленцев. Построенный на ускорителях AMD Instinct и центральных процессорах EPYC суперкомпьютер Frontier первым в истории преодолел барьер производительности вычислений в один эксафлопс, он с мая 2022 года считается самым мощным в мире. Томас Закария получил высшее образование в Индии по профилю инженера-механика, а затем прошёл магистратуру в области материаловедения в США, и там же получил степень доктора технических наук. Путин поручил нарастить мощность отечественных суперкомпьютеров на порядок

29.02.2024 [15:55],

Владимир Фетисов

Президент России Владимир Путин поручил правительству разработать и осуществить реализацию мер, направленных на увеличение вычислительных мощностей отечественных суперкомпьютеров. Об этом было сказано во время оглашения послания Федеральному Собранию, а на официальном сайте Кремля уже опубликован список поручений, сформированный по итогам конференции «Путешествие в мир искусственного интеллекта».

Источник изображения: pixabay.com «Правительству Российской Федерации: разработать и реализовать комплекс мер, направленных на увеличение вычислительных мощностей суперкомпьютеров, находящихся в Российской Федерации, определив конкретные параметры увеличения этих мощностей», — сказано в перечне поручений президента. Кабинет министров также должен разработать механизмы использования архивов государственных и муниципальных органов и библиотечных фондов для создания наборов данных, которые могут быть использованы на безвозмездной основе. Ответственным за исполнение поручений назначен премьер-министр России Михаил Мишустин, а доклад об исполнении поручений глава государства ждёт к 1 марта. «Так, в 2030 году совокупная мощность отечественных суперкомпьютеров должна быть увеличена не менее чем в 10 раз. Это абсолютно реалистичная задача<…> В целом, необходимо развивать всю инфраструктуру экономики данных. Я прошу правительство предложить конкретные меры поддержки компаний и стартапов, которые производят оборудование для хранения и обработки данных, а также создают программное обеспечение», — сказал Владимир Путин во время оглашения послания Федеральному Собранию. Стоит отметить, что на данный момент в суперкомпьютерный рейтинг TOP500 входит лишь семь отечественных суперкомпьютеров. Самый мощный из них, принадлежащий «Яндексу» «Червоненкис» находится на 36-м месте в рейтинге с производительностью 21,5 Пфлопс. При этом лидер рейтинга, американский экзафлопсный суперкомпьютер Frontier превосходит российскую систему по производительности более чем в 50 раз. Что касается самих поручений президента, то правительству предстоит реализовать выполнение следующих шагов:

Отметим, что в этом году в стране началась реализация национального проекта, направленного на развитие экономики на основе данных, генерируемых в цифровых системах — как бизнеса, так и государства. Этот проект является продолжением национального проекта «Цифровая экономика». Помимо прочего новая инициатива предполагает разработку программы по созданию и закупке комплектующих, а также созданию суперкомпьютеров на территории России. NVIDIA запустила девятый по мощности суперкомпьютер в мире — Eos получил 4608 ИИ-ускорителей H100

17.02.2024 [13:07],

Павел Котов

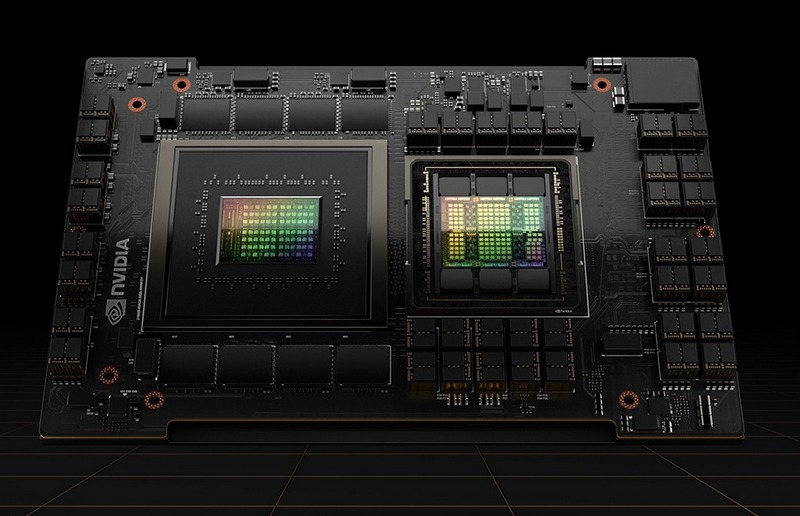

NVIDIA официально представила суперкомпьютер Eos, предназначенный для приложений искусственного интеллекта. Он оснащён 576 системами NVIDIA DGX H100, каждая из которых включает 8 ускорителей H100 — всего 4608 единиц. Системы подключены с использованием архитектуры NVIDIA Quantum-2 InfiniBand (400 Гбит/с). Также суперкомпьютер включает 1152 процессора Intel Xeon Platinum 8480C, каждый из которых предлагает 56 ядер.

Источник изображения: nvidia.com Суперкомпьютер NVIDIA Eos предлагает производительность для ИИ-приложений в 18,4 Эфлопс (FP8), а также обеспечит около 9 Эфлопс в рассчётах FP16 и 275 Пфлопс в FP64. Компания анонсировала его почти год назад и рассказывала подробнее о нём на выставке Supercomputing 2023 в ноябре минувшего года — теперь он готов начать работу. Разработчик отмечает, что Eos способен справиться с самыми большими рабочими нагрузками в области ИИ для обучения больших языковых моделей, рекомендательных алгоритмов, квантового моделирования и многого другого. Суперкомпьютер занимает девятое место в рейтинге TOP500. Высокую производительность NVIDIA Eos обеспечивают мощные ускорители и интерфейсы компании NVIDIA, а также её ПО, такое как NVIDIA Base Command и NVIDIA AI Enterprise. «Архитектура Eos оптимизирована для рабочих нагрузок ИИ, требующих сверхмалой задержки и высокой пропускной способности соединений внутри кластера ускорителей, что делает её идеальным решением для предприятий, стремящихся масштабировать свои комплексы ИИ. В то время как корпорации и разработчики по всему миру стремятся задействовать возможности ИИ, Eos становится основным ресурсом, который обещает ускорить путь к приложениям на базе ИИ для каждой организации», — отметила NVIDIA. Мощь 52 ускорителей NVIDIA H200 за 1/100 стоимости — Tachyum начнёт массово выпускать 192-ядерные чипы Prodigy в этом году

29.01.2024 [18:31],

Николай Хижняк

Компания Tachyum сообщила, что в этом году начнёт массовое производство универсального процессора Prodigy, сочетающего вычислительные и графические ядра, а также нейродвижок TPU. Производитель обещает, что новинка обеспечит выдающийся уровень производительности и сможет потягаться с самыми мощными ускорителями вычислений NVIDIA.

Источник изображения: Tachyum Разработчик заявляет, что её 192-ядерный чип, выполненный на основе 5-нм технологического процесса, обеспечивает в 4,5 раза более высокую производительность, чем любой другой процессор, предназначенный для вычислительных нагрузок в облачной среде. Кроме того, он до трёх раз быстрее любого GPU, предназначенного для высокопроизводительных вычислений и до шести раз энергетически эффективнее специализированных GPU для ИИ-задач. Tachyum анонсировала чип Prodigy Universal Processor в 2022 году и пообещала с его помощью трансформировать узкоспециализированные ЦОДы в универсальные компьютерные центры, способные обеспечить необходимую вычислительную мощность и эффективность для различных ИИ-нагрузок. В декабре 2023 года компания выпустила видео, показывающее способность Prodigy эмулировать работу в x86-совместимых приложениях. Однако есть одно существенное «но»: несмотря на внушительные цифры производительности и заявления Tachyum, процессоры Prodigy существуют только на бумаге и в виде эмулируемой с помощью FPGA платформы с небольшим количеством ядер. «Успехи, которых нам удалось достичь при корректировке нашего плана выпуска продуктов, привели нас к 2024 году, полному ожиданий, поскольку мы движемся к началу массового производства Prodigy и реализации многомиллиардного канала продаж. Мы с нетерпением ждём возможности выполнить наше обещание и обязательство по преобразованию обычных центров обработки данных в универсальные вычислительные центры в ближайшем будущем», — заявил генеральный директор и основатель Tachyum Радослав Данилак (Radoslav Danilak). Поскольку в составе Prodigy Universal Processor используются функциональные компоненты, предназначенные для разных типов нагрузок, он может динамически переключаться между вычислительными кластерами, исключая необходимость в использовании разнонаправленного и дорогостоящего аппаратного обеспечения для отдельных типов ИИ-нагрузок в составе вычислительной системы. По крайней мере, так говорится в свежем пресс-релизе компании. Там же заявляется, что всего один процессор Prodigy Universal Processor стоимостью $23 000 способен сравниться по производительности в задачах обучения ИИ с системой из 52 специализированных ускорителей NVIDIA H200, являющихся одними из лучших на рынке. Компания заявила, что стоимость такого количества графических процессоров в составе семи серверов Supermicro GPU составит 2 349 028 долларов или в 100 раз больше, чем одна система с Prodigy Universal Processor и 2 Тбайт оперативной памяти DDR5. Tachyum также заявила, что уже планирует разработку более передового универсального процессора Prodigy 2 на базе 3-нм техпроцесса, который получит поддержку интерфейсов PCIe 6.0 и CXL, и будет оснащаться набортной высокопроизводительной памятью HBM3. Его планируется выпустить где-то в 2026 году. Первый в мире суперкомпьютер с производительностью человеческого мозга начали строить в Австралии

14.12.2023 [17:47],

Павел Котов

Австралийские учёные приступили к созданию суперкомпьютера, имитирующего самую эффективную в мире обучающуюся машину — речь идёт о нейроморфной системе, способной выполнять те же 228 трлн синаптических операций в секунду, что и человеческий мозг.

Источник изображения: westernsydney.edu.au По мере вступления эпохи искусственного интеллекта в свои права приходит понимание, что этот технологический скачок является одним из наиболее значительных в истории цивилизации, и скоро ИИ глубоко проникнет во все сферы нашей жизни. Но ему требуются колоссальные вычислительные мощности, и при сохранении нынешней тенденции, когда NVIDIA является единственным поставщиком ИИ-ускорителей, отрасль рискует выйти на энергопотребление, сравнимое с нуждами небольших стран. При этом человеческий мозг так и остаётся самым совершенным компьютером, потребляющим всего 20 Вт энергии. Это побудило учёных из Университета Западного Сиднея (Австралия) запустить проект по созданию нейроморфного суперкомпьютера DeepSouth — первой в мире машины, моделирующей импульсные нейронные сети в масштабах человеческого мозга. «Прогресс в понимании того, как мозг производит вычисления при помощи нейронов, сдерживает наша неспособность моделировать подобные мозгу сети в больших масштабах. Смоделированные импульсные нейросети на стандартных компьютерах с использованием графических (GPU) и многоядерных центральных процессоров (CPU) слишком медленны и энергоёмки. Наша система это изменит. Платформа поможет улучшить наше понимание мозга и разработать вычислительные приложения в масштабах мозга в различных областях, включая сенсорику, биомедицину, робототехнику, космос и крупномасштабные приложения искусственного интеллекта», — прокомментировал проект профессор Андре ван Шайк (André van Schaik), директор Международного центра нейроморфных систем при Университете Западного Сиднея. Как ожидается, DeepSouth будет запущен в апреле 2024 года. Он сможет обрабатывать большие объёмы данных с высокой скоростью, оставаясь меньше других суперкомпьютеров и потребляя гораздо меньше энергии благодаря архитектуре импульсной нейронной сети, говорят учёные. Система является модульной и масштабируемой — она содержит доступное на рынке оборудование, а значит, в будущем её можно будет расширять или, напротив, сокращать для решения конкретных задач. Цель проекта — приблизить системы ИИ к механизмам работы человеческого мозга, изучить механизмы работы мозга и при благополучном исходе добиться успехов, актуальных в других областях. Примечательно, что другие исследователи подошли к той же проблеме с диаметрально противоположной стороны: недавно американские учёные вырастили ткань человеческого мозга, подключили её к компьютеру и добились впечатляющих результатов. Из Tesla ушёл руководитель проекта суперкомпьютера Dojo для обучения автопилота

07.12.2023 [22:02],

Николай Фрей

Руководитель проекта по созданию суперкомпьютера Dojo компании Tesla Ганеш Венкатараманан (Ganesh Venkataramanan) покинул свой пост. Его заменит один из директоров компании Tesla Питер Бэннон (Peter Bannon). Суперкомпьютер Dojo разрабатывается для обработки больших массивов данных для обучения автопилота для электромобилей Tesla.

Источник изображения: Tesla Венкатараманан, возглавлявший проект Dojo в течение последних пяти лет, уволился из компании в прошлом месяце. Питер Бэннон прежде занимал руководящую должность в Apple, а также работал в других технологических компаниях. До нового назначения в Tesla он в течение последних семи лет также занимал руководящие должности. Суперкомпьютер Dojo предназначен для обработки огромных массивов данных, включая видеофайлы, получаемые с камер автомобилей Tesla. Данные необходимы для обучения специализированного программного обеспечения для автономного вождения. В основе Dojo лежит фирменный чип D1 компании Tesla. В последние недели Tesla также установила оборудование для проекта Dojo в дата-центре в Пало-Альто, в Калифорнии. Проект подразумевает использование нескольких центров обработки данных, расположенных в разных местах. NVIDIA и Amazon анонсировали мощнейший облачный ИИ-суперкомпьютер Project Ceiba

28.11.2023 [23:56],

Андрей Созинов

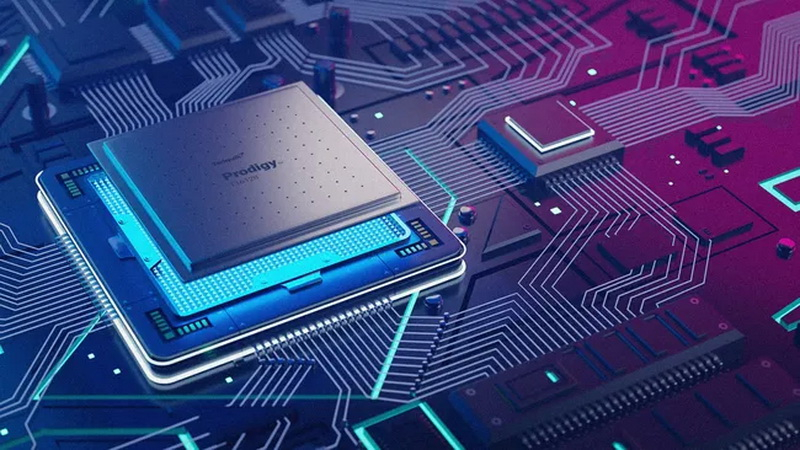

Компания NVIDIA совместно с облачным провайдером Amazon Web Services (AWS) представила ряд новых совместных решений, в основном, связанных с ИИ. Компании анонсировали мощные системы NVIDIA GH200 NVL32 для обучения и запуска нейросетей, а также объявили о создании на основе этих систем самого мощного облачного ИИ-суперкомпьютера в мире — Project Ceiba.

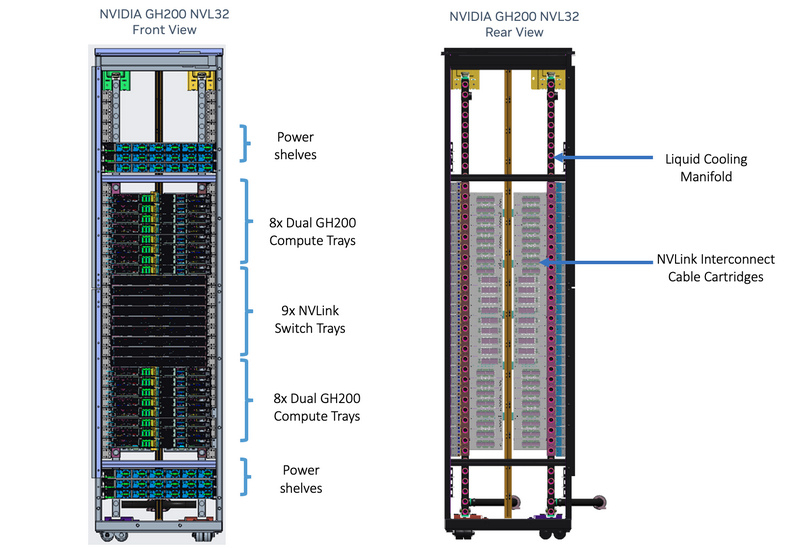

Project Ceiba. Источник изображений: NVIDIA NVIDIA GH200 NVL32 представляет собой готовую систему, выполненную в формате стандартной серверной стойки. Она объединяет 32 гибридных ускорителя NVIDIA GH200 Grace Hopper Superchip, которые представляют собой двухчиповую систему из центрального процессора с 72 ядрами Arm Neoverse и графического процессора NVIDIA H100. Такая стойка сможет обеспечить выдающуюся производительность — до 128 Пфлопс в операциях FP8 (квадриллионов операций в секунду).

NVIDIA GH200 Grace Hopper Superchip Система обладает 2304 процессорными Arm-ядрами, 20 Тбайт оперативной памяти, включая 4,5 Тбайт HBM3e с общей пропускной способностью 157 Тбайт/с. За связь между суперчипами GH200 отвечают девять коммутаторов NVSwitch и интерфейс NVLink с общей пропускной способностью 57,6 Тбайт/с. Применяется система жидкостного охлаждения. AWS первой предложит системы GH200 NVL32 в составе облачной платформы NVIDIA DGX Cloud. Более того, Amazon даст возможность клиентам объединять новые системы NVIDIA в кластеры EC2 UltraClasters, получая в своё распоряжение тысячи ускорителей GH200 Superchip. По словам самой NVIDIA, системы GH200 NVL32 идеально подходят как для обучения, так и для запуска крупных нейросетей — даже с 1 трлн параметров.

Устройство NVIDIA GH200 NVL32 Также компании анонсировали создание Project Ceiba — самого быстрого в мире суперкомпьютера для ИИ на базе GPU. Система обеспечит производительность 65 Эксафлопс (FP8). Она объединит в себе 16 384 ускорителя GH200, а также 9,1 Пбайт памяти и обеспечит общую пропускную способность интерконнекта на уровне 410 Тбайт/с. Суперкомпьютер будет частью облака AWS DGX Cloud и станет доступен клиентам AWS в следующем году. Стив Скотт присоединился к AMD: новый виток в развитии суперкомпьютерных технологий

28.11.2023 [04:26],

Дмитрий Федоров

Компания AMD недавно объявила о значительном усилении своей команды ветераном индустрии суперкомпьютеров Стивом Скоттом (Steve Scott). Его переход в AMD не только символизирует новый этап в карьере признанного специалиста, но и предвещает значительные изменения для самой компании.

Источник изображения: servernews.ru Начав свою карьеру в Cray Research в 1992 году, Скотт прошёл путь от простого разработчика до корпоративного научного сотрудника, старшего вице-президента и технического директора. Важной вехой в его карьере стал проект Red Storm, который спас Cray Research от банкротства и вернул компанию на путь инноваций. Переход Скотта в AMD после работы в организации архитектуры оборудования Azure в Microsoft, где он руководил созданием облачных суперкомпьютеров, является логичным шагом в его блестящей карьере. Стив Скотт известен своим вкладом в развитие технологий суперкомпьютеров. В Cray Research он занимался разработкой новаторских архитектур вычислительных систем, что способствовало прорывам в области высокопроизводительных вычислений. Его работа в NVIDIA, Google и возврат в Cray, а также роль в HPE после приобретения Cray Research за $1,3 млрд, подчёркивают его высокую компетенцию в сфере высокопроизводительных вычислений. Скотт поделился на LinkedIn своими ожиданиями от работы в AMD: «Я глубоко впечатлён технологиями и планами AMD и всегда с удовольствием работал с командой AMD». Его опыт и знания в области архитектуры высокопроизводительных вычислительных систем и суперкомпьютеров будут ключевыми в разработке новых продуктов AMD, особенно в области ИИ и облачных технологий. Переход Скотта в AMD — это не просто перемещение высококвалифицированного специалиста между компаниями. Это событие, которое может радикально изменить ландшафт суперкомпьютерных технологий. Его опыт в создании инновационных архитектур и управлении сложными проектами в высокопроизводительных вычислениях позволит AMD укрепить свои позиции на мировом рынке и открыть новые горизонты в разработке передовых технологий. Китай создал 384-ядерный чип Sunway SW26010-Pro для суперкомпьютеров, который в 4 раза быстрее предшественника

25.11.2023 [12:37],

Павел Котов

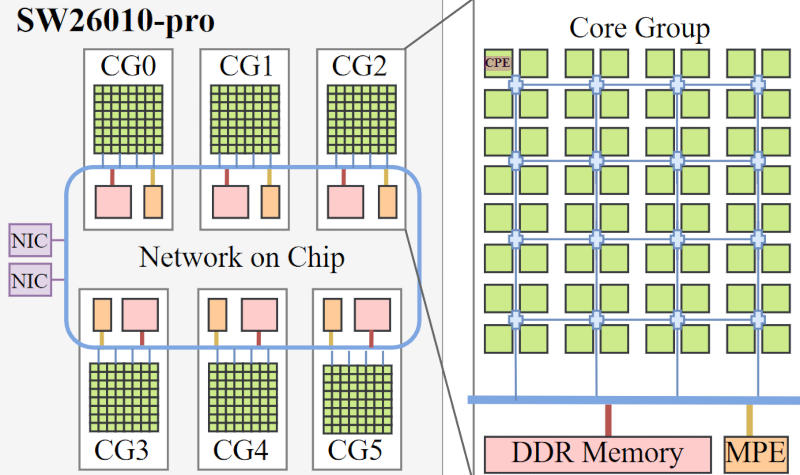

В этом году Национальный суперкомпьютерный центр в Уси (Китай) запустил мощнейший суперкомпьютер на базе усовершенствованных 384-ядерных процессоров Sunway SW26010-Pro, разработанных в стране. По сравнению с предшественником — 256-ядерной моделью Sunway SW26010 без приставки «Pro» — его производительность выросла до четырёх раз, сообщает ресурс Chips and Cheese.

Источник изображения: top500.org Впервые о процессоре Sunway SW26010-Pro и суперкомпьютерах на его основе стало известно ещё в 2021 году, но только в этом году на конференции по высокопроизводительным вычислениям SC23 разработчик публично продемонстрировал этот чип и рассказал о его архитектуре. Максимальная FP64-производительность каждого Sunway SW26010-Pro составляет 13,8 Тфлопс — для сравнения, 96-ядерный AMD EPYC 9654 демонстрирует около 5,4 Тфлопс. Sunway SW26010-Pro основан на совершенно новой проприетарной RISC-архитектуре — он включает в себя шесть групп ядер (CG) и блок обработки протоколов (Protocol Processing Unit — PPU). Каждый CG-кластер объединяет 64 вычислительных ядра (Compute Processing Elements — CPE) с 512-битным векторным движком, 256 кбайт сверхскоростного кеша для данных и 16 кбайт для инструкций; одно управляющее ядро (Management Processing Element — MPE) — суперскалярное ядро внеочередного действия с векторным движком, по 32 Кбайт кеша L1 для данных и инструкций, 512 Кбайт кеша L2; а также 128-битный интерфейс памяти DDR4-3200.

Источник изображения: chipsandcheese.com MPE и CPE используют протокол на основе директорий — он обеспечивает согласованный обмен данными, чтобы сократить объём их перемещения между ядрами и поддержать точное взаимодействие между ними. Это особенно важно для приложений с нерегулярным доступом к совместно используемым данным. Каждый 6-кластерный процессор имеет 384 вычислительных и 6 управляющих ядер — всего 390 ядер. Sunway SW26010-Pro отличается от предшественника более высокой скоростью работы (2,25 ГГц у CPE и 2,10 ГГц у MPE против 1,45 ГГц у обоих на предыдущей модели) и полностью переработанной 64-разрядной RISC-архитектурой, которая помогла увеличить FP64-производительность в четыре раза. Разработчик повысил пропускную способность памяти, заменив контроллеры DDR3 на DDR4. Если у предыдущей версии процессора на один CPE-кластер приходились 8 Гбайт DDR3, то сейчас это 16 Гбайт DDR4 — соответственно, общий объём поддерживаемой процессором памяти вырос с 32 Гбайт у SW26010 до 96 Гбайт в SW26010-Pro. При этом, как отмечает Tom’s Hardware, слабым местом обоих версий процессора являются кеш и оперативная память. В модели SW26010-Pro проблему с кешем попытались решить, увеличив объём сверхскоростной памяти с 64 до 256 Кбайт, но при отсутствии надлежащего L2 этого всё равно недостаточно. Двухканальной подсистемы памяти DDR4-3200 (51,2 Гбайт/с), кроме того, едва хватает на 64 ядра, каждое из которых имеет 512-битный векторный FPU и обеспечивает производительность до 16 FP64-флопс за цикл. Проблему кеша можно частично компенсировать за счёт дорогостоящей и трудозатратной программной оптимизации, но с учётом недостаточной пропускной способности ОЗУ непонятно, насколько в итоге обновлённый процессор окажется эффективным для задач, которые призваны решать экзафлопсные суперкомпьютеры. Стартап выходцев из «Яндекса» Nebius ворвался на 16-е место мощнейших суперкомпьютеров мира — «Яндекс» и «Сбер» остались далеко позади

16.11.2023 [12:33],

Владимир Мироненко

Компания Nebius N.V. со штаб-квартирой в Нидерландах, основанная бывшими сотрудниками «Яндекса», дебютировала в мировом рейтинге суперкомпьютеров TOP500. Её система ISEG заняла сразу 16-ю строку в списке, оставив позади системы «Яндекса» и «Сбера».

Источник изображения: Pixabay Проект Nebius базируется в Израиле, а руководит им Роман Чернин, ранее возглавлявший в «Яндексе» подразделение геосервисов. «Как мы туда попали [в TOP500]? Наша команда разработчиков с большим энтузиазмом отнеслась к тестированию той части нашей новой облачной платформы, которая на тот момент была свободна от рабочей нагрузки клиентов, — сообщила в своём аккаунте LinkedIn отделившаяся от «Яндекса» Nebius. — Для этой цели они использовали бенчмарк из TOP500. Теперь вы можете использовать часть суперкомпьютера Nebius AI для своих проектов в области искусственного интеллекта». В том, что запустившийся в начале года стартап Nebius уже создал свой суперкомпьютер, причём один из самых производительных в мире, нет ничего удивительного. Например, у «Сбера» в своё время на создание суперкомпьютера ушло всего три-четыре месяца. Как отметили в «Яндексе», при строительстве суперкомпьютера ISEG интеллектуальная собственность и технологии «Яндекса» не использовались, потому как они там не требуются. Тестирование суперкомпьютера для TOP500 проводилось на «голом железе», но для реального применения потребуется уже специальное ПО, и Nebius может использовать как собственные разработки, так и решения с открытым кодом. «Система Nebius потенциально имела шансы появиться в России, это потерянная возможность», — прокомментировал вхождение в TOP500 стартапа Nebius главный научный сотрудник, директор Исследовательского центра мультипроцессорных систем Института программных систем им. А. К. Айламазяна Российской академии наук, член-корреспондент РАН, сокоординатор Национальной суперкомпьютерной технологической платформы Сергей Абрамов. Два года назад Абрамов оценивал стоимость создания суперкомпьютера «Яндекса «Червоненкис» в $7–10 млн. С учётом использования параллельного импорта в условиях санкций на создание подобного суперкомпьютера сейчас потребуется $10,5–20 млн. Учёный отметил, что для создания «серьёзных систем» необходима тесная кооперация с мировыми производителями процессоров, ускорителей, интерконнекта, о чём в условиях санкций говорить не приходится. В новом рейтинге TOP500 всего семь суперкомпьютеров из России. Все они утратили прежние позиции. Наиболее мощный российский суперкомпьютер «Червоненкис», созданный «Яндексом» в 2021 году, опустился с 27-го на 36-е место. В свою очередь «Галушкин» опустился с 46-го на 58-е, а «Ляпунов» — с 52-го на 64-е. Это тоже системы «Яндекса». На 67-е место с 55-го упал суперкомпьютер «Кристофари Нео», а на 119-е место переместился с 96-го «Кристофари» — обе системы принадлежат «Сберу». На 370-е место с 329-го переместился суперкомпьютер «Ломоносов-2» производства компании «Т-Платформы», установленный в Научно-исследовательском вычислительном центре МГУ, и на 433-м месте оказался суперкомпьютер MTS GROM, установленный в CloudMTS, ранее занимавший 391-ю позицию. Источник Forbes назвал утрату российскими компаниями прежних позиций в TOP500 «естественным результатом санкций». С уходом американских корпораций с российского рынка у оставшихся в стране компаний нет «объективных технологических возможностей выступать с какими-то новыми результатами» в рейтинге TOP500, считает собеседник Forbes. В «Яндексе» объяснили изменение места в рейтинге тем, что организаторы использовали старые данные. «Компания использует все свои суперкомпьютеры для различных сервисов, в том числе для обучения модели YandexGPT, — сообщила «Яндекс» ресурсу Forbes . — Изменение места в рейтинге связано с тем, что мы не проводили новые замеры для TOP500, так как для проведения тестов необходимо остановить все рабочие процессы обучения моделей на суперкомпьютерах. Поэтому организаторы использовали наши старые данные от ноября 2021 года». Aurora на базе Intel стал вторым мощнейшим суперкомпьютером в мире — лидером остался вдвое более мощный Frontier на AMD

14.11.2023 [16:19],

Павел Котов

Проект Top500 обновил рейтинг самых быстрых суперкомпьютеров в мире. Первое место сохранила система Frontier на базе процессоров и ускорителей AMD с производительностью 1,194 Эфлопс. А вот второе место претерпело изменения. Здесь, уступив лидеру более чем вдвое, оказался основанный на чипах Intel суперкомпьютер Aurora Аргоннской национальной лаборатории (США) — он показал 585,34 Пфлопс.

Источник изображения: intel.com Intel осуществила мощную атаку на рейтинг суперкомпьютеров, добавив в список 20 новых систем на чипах Sapphire Rapids. В то же время места в Top500 активно занимают системы на AMD EPYC — на этих процессорах работают уже 140 суперкомпьютеров в списке, а за год их число выросло на 39 %. Intel и Аргоннская лаборатория продолжают работу по расширению Aurora: на момент выхода последней версии рейтинга суперкомпьютер составляли 10 624 процессора и 31 874 графических ускорителя Intel, обеспечивших производительность в 585,34 Пфлопс при суммарной мощности 24,69 МВт. Для сравнения, лидер рейтинга в лице Frontier на чипах AMD имеет производительность в 1,194 Эфлопс, более чем двукратно опережая систему на втором месте и потребляя при этом относительно скромные 22,70 МВт энергии. Из-за этого Aurora не попал в рейтинг самых энергоэффективных суперкомпьютеров Green500, а Frontier удерживает здесь восьмое место. Ожидается, что в конечном итоге Aurora выйдет на производительность в 2 Эфлопс — её обеспечат 21 248 процессоров Xeon Max и 63 744 графических ускорителя Max Ponte Vecchio в 166 стойках и 10 624 вычислительных модулях. Это будет самый крупный массив графических процессоров в мире. Суперкомпьютер работает на узлах HPE Cray EX с сетевыми соединениями HPE Slingshot-11. Тем временем AMD занимается строительством суперкомпьютера El Capitan в Ливерморской национальной лаборатории имени Лоуренса (США), который, как ожидается, превысит показатель в 2 Эфлопс, и, возможно, Aurora уже не поднимется до первого места.

Источник изображения: olcf.ornl.gov Впервые о суперкомпьютере Aurora было объявлено в 2015 году. Его строительство планировали завершить в 2018 году — тогда ожидалось, что он будет работать на процессорах Knights Hill, выход которых впоследствии был отменён. В 2019 году был анонсирован обновлённый проект Aurora с производительностью около 1 Эфлопс, который намеревались завершить к 2021 году. Но в конце 2021 года проектную производительность повысили до 2 Эфлопс, а сроки продлили до 2024 года. Третьим в рейтинге оказался новый суперкомпьютер Eagle (561,20 Пфлопс) от Microsoft, развёрнутый в облаке Azure — облачный суперкомпьютер обогнал прежнего серебряного лауреата в лице японского суперкомпьютера Fugaku (442,01 Пфлопс), который опустился на четвёртое место. А замкнула пятёрку финская система LUMI с 379,70 Пфлопс. Китай намерен нарастить свои вычислительные мощности на 52 % за два года, несмотря на санкции

09.10.2023 [09:49],

Алексей Разин

Введённые год назад ограничения на поставку в Китай ускорителей вычислений американского происхождения были направлены на сдерживание технологического развития страны. Власти КНР не стесняются даже в сложных условиях ставить перед национальной вычислительной инфраструктурой амбициозные цели. В технологическом секторе Китай рассчитывает увеличить вычислительные мощности к 2025 году более чем на 50 %.

Источник изображения: NVIDIA Об этом стало известно с подачи Bloomberg — агентство ссылается на совместное заявление ряда китайских ведомств и Министерства промышленности и информатизации КНР. В промышленной сфере совокупную вычислительную мощностью эксплуатируемых в стране серверных систем планируется увеличить с нынешних 197 до 300 экзафлопс или примерно на 52 % уже к 2025 году. К концу текущего года мощность должна составить уже 220 Эфлопс. За два ближайших года в Китае также появится 20 дополнительных центров обработки данных новейшего поколения. Попутно будут развиваться оптические сети передачи информации и системы хранения данных, по замыслу китайских чиновников, среднее время задержки при передаче информации в критически важных системах не должно превышать 5 мс. За счёт этого предполагается придать дополнительный импульс развитию производства, образования, транспорта, здравоохранения, энергетики и финансовой сферы. Отдельное внимание будет уделяться развитию отечественного программного обеспечения, повышающего надёжность функционирования всей этой инфраструктуры. Власти КНР подчеркнули, что стабильность поставок компонентов будет существенно влиять на успех в реализации данной программы. В контексте ожидания новых санкций со стороны США это звучит тем более актуально. Год назад США ввели экспортные ограничения на поставку в Китай как определённых видов оборудования для производства чипов, так и компонентов для центров обработки данных, обладающих определённым уровнем быстродействия. По всей видимости, этой осенью перечень ограничений будет расширен, что создаст дополнительные сложности для китайской стороны в реализации своих инициатив. TSMC активно наращивает выпуск гигантских чипов для суперкомпьютера Tesla Dojo

27.09.2023 [11:16],

Алексей Разин

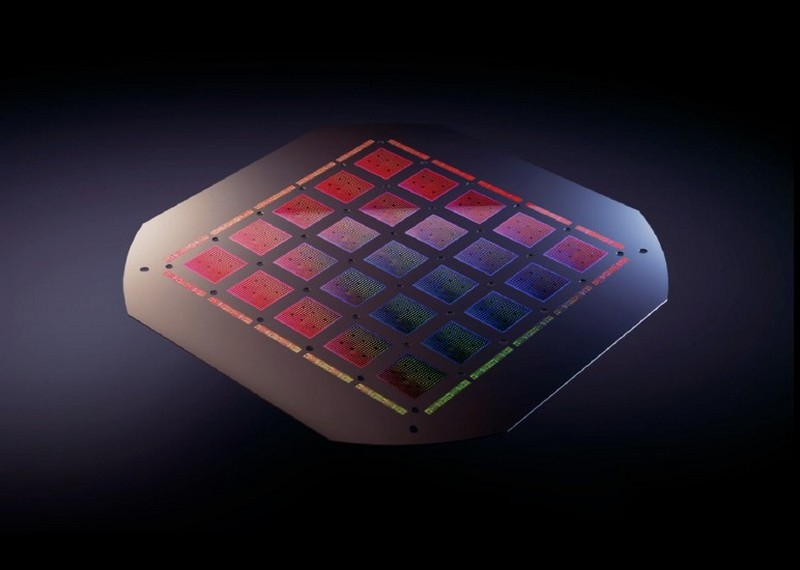

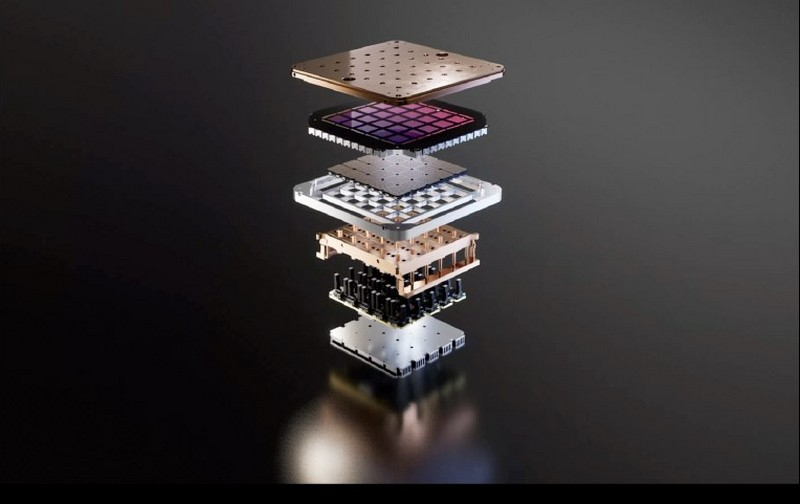

В конце августа прошлого года компания Tesla рассказала об архитектуре своей суперкомпьютерной системы Dojo, которая будет применяться для работы с фирменными системами искусственного интеллекта, ориентированными на машинное зрение и автоматическое управление транспортом. Как отмечают тайваньские источники, компоненты для этого суперкомпьютера Tesla заказывает у TSMC весьма активно.

Источник изображений: Tesla Основной компонент, на котором строится суперкомпьютер Tesla Dojo — это чип D1 собственной разработки, который представляет собой «систему-на-пластине», то есть занимает целую 300-мм кремниевую пластину, на которой размещается 25 ускорителей и другие функциональные элементы. Его компания TSMC производит по 7-нм технологии и упаковывает особым образом, что уже стало нормой для ускорителей вычислений. В этом году Tesla собирается закупить у TSMC около 5000 таких чипов, в следующем году она намерена удвоить количество до 10 000 чипов, а также продолжить наращивание закупок уже в 2025 году.  Для TSMC увеличение объёмов заказов на выпуск 7-нм продукции является положительной тенденцией, поскольку на фоне снижения спроса на компоненты для смартфонов данное направление деятельности страдало от снижения уровня загрузки производственных линий. По крайней мере, в следующем году за счёт заказов Tesla и прочих клиентов степень загрузки линий на 7-нм направлении вырастет до оптимальных величин. К концу 2024 года Tesla намеревается довести уровень производительности своего суперкомпьютера Dojo до 100 эксафлопс, поэтому процесс масштабирования системы продолжается. Tesla запустила суперкомпьютер на 10 тыс. ускорителей NVIDIA H100 — на нём будут учить автопилот

30.08.2023 [21:06],

Николай Хижняк

Компания Tesla сообщила о запуске на этой неделе нового суперкомпьютера для решения ресурсоемких задач, связанных с ИИ. В его основе используются 10 тыс. специализированных графических ускорителей NVIDIA H100.

Источник изображений: HPC Wire Отмечается, что система обеспечивает пиковую производительность в 340 Пфлопс в операциях FP64 для технических вычислений и 39,58 Эфлопс в операциях INT8 для задач ИИ. Таким образом, по производительности FP64 кластер превосходит суперкомпьютер Leonardo, который располагается на четвёртой позиции в нынешнем мировом рейтинге суперкомпьютеров Тор500 с показателем 304 Пфлопс. Новый суперкомпьютер Tesla с ускорителями NVIDIA H100 является одной из самых мощных платформ в мире. На формирование кластера потрачено около $300 млн. Он подходит не только для обработки алгоритмов ИИ, но и для НРС-задач. Благодаря данной системе компания рассчитывает значительно расширить ресурсы для создания полноценного автопилота. На фоне сформировавшегося дефицита ускорителей NVIDIA H100 компания хочет диверсифицировать вычислительные мощности. Для этого Tesla ведёт разработку своего собственного проприетарного суперкомпьютера Dojo. В проект планируется инвестировать $1 млрд. Уже к октябрю следующего года Tesla рассчитывает преодолеть барьер в 100 Эфлопс производительности, что более чем в 60 раз мощнее самого производительного суперкомпьютера в мире на сегодняшний день. Помимо простого аппаратного обеспечения, новая вычислительная инфраструктура предоставит Tesla преимущество в обработке огромных наборов данных, что имеет решающее значение для реальных сценариев обучения ИИ. |