|

Опрос

|

реклама

Быстрый переход

Сроки поставок ИИ-ускорителей Nvidia H100 сократились до 2–3 месяцев

10.04.2024 [20:59],

Николай Хижняк

Cроки поставок ИИ-ускорителей Nvidia H100 сократились с 3–4 до 2–3 месяцев (8–12 недель), сообщает DigiTimes со ссылкой на заявление директора тайваньского офиса компании Dell Теренса Ляо (Terence Liao). ODM-поставщики серверного оборудования отмечают, что дефицит специализированных ускорителей начал снижаться по сравнению с 2023 годом, когда приобрести Nvidia H100 было практически невозможно.

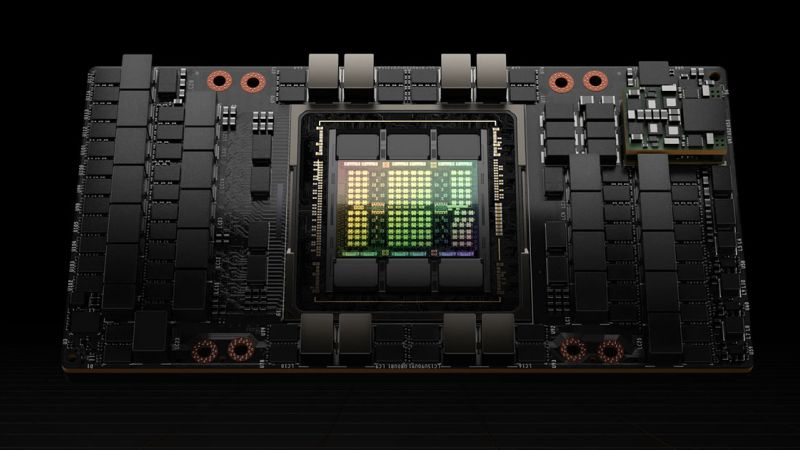

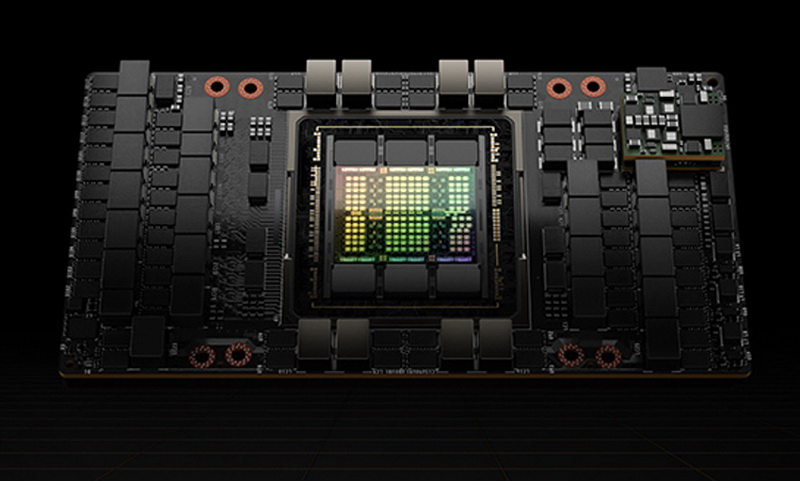

Источник изображения: Nvidia По словам Ляо, несмотря на сокращение сроков выполнения заказов на поставки ИИ-ускорителей, спрос на это оборудование на рынке по-прежнему чрезвычайно высок. И несмотря на высокую стоимость, объёмы закупок ИИ-серверов значительно выше закупок серверного оборудования общего назначения. Окно поставок в 2–3 месяца — это самый короткий срок поставки ускорителей Nvidia H100 за всё время. Всего шесть месяцев назад он составлял 11 месяцев. Иными словами, клиентам Nvidia приходилось почти год ждать выполнение своего заказа. С начала 2024 года сроки поставок значительно сократились. Сначала они упали до 3–4 месяцев, а теперь до 2–3 месяцев. При таком темпе дефицит ИИ-ускорителей может быть устранён к концу текущего года или даже раньше. Частично такая динамика может быть связана с самими покупателями ИИ-ускорителей. Как сообщается, некоторые компании, имеющие лишние и нигде не использующиеся H100, перепродают их для компенсации огромных затрат на их приобретение. Также нынешняя ситуация может являться следствием того, что провайдер облачных вычислительных мощностей AWS упростил аренду ИИ-ускорителей Nvidia H100 через облако, что в свою очередь тоже частично помогает снизить на них спрос. Единственными клиентами Nvidia, которым по-прежнему приходится сталкиваться с проблемами в поставках ИИ-оборудования, являются крупные ИИ-компании вроде OpenAI, которые используют десятки тысяч подобных ускорителей для быстрого и эффективного обучения своих больших языковых ИИ-моделей. ИИ-ускоритель Intel Gaudi2 оказался на 55 % быстрее Nvidia H100 в тестах Stable Diffusion 3, но есть нюанс

12.03.2024 [18:34],

Сергей Сурабекянц

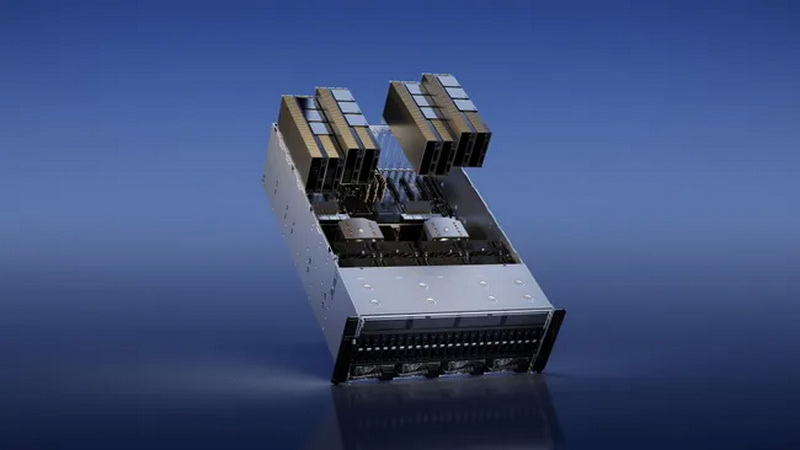

Компания Stability AI, разработчик популярной модели генеративного ИИ Stable Diffusion, сравнила производительность модели Stable Diffusion 3 на популярных ускорителях вычислений для центров обработки данных, включая Nvidia H100 Hopper, A100 Ampere и Intel Gaudi2. По утверждению Stability AI, Intel Gaudi2 продемонстрировал производительность примерно на 56 % выше, чем Nvidia H100.

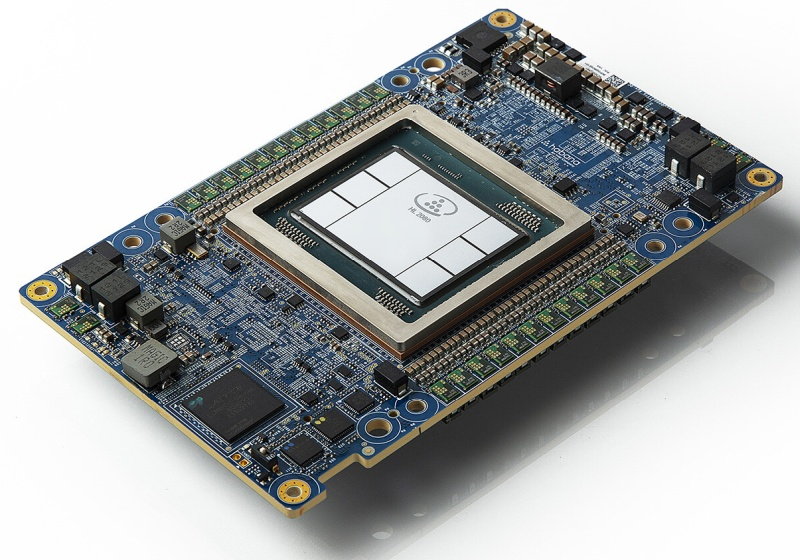

Источник изображения: Intel В отличие от H100, который представляет собой суперскалярный графический процессор с тензорными CUDA-ядрами, Gaudi2 специально спроектирован для ускорения генеративного ИИ и больших языковых моделей (LLM). В тестах приняли участие пары кластеров, которые в сумме обеспечивали по 16 тех или ускорителей, а проводились тесты с постоянным размером батча (число тренировочных объектов) в 16 на каждый ускоритель (всего 256). Системы на Intel Gaudi2 оказались способны генерировать 927 изображений в секунду по сравнению с 595 изображениями для ускорителей H100 и 381 изображением в секунду для массива A100.

Источник изображения: Stability AI При увеличении количества кластеров до 32, а числа ускорителей до 256 и размере батча 16 на ускоритель (общий размер 4096), массив Gaudi2 генерирует 12 654 изображения в секунду или 49,4 изображения в секунду на ускоритель, по сравнению с 3992 изображениями в секунду или 15,6 изображениями в секунду на устройство у массива A100 Ampere.

Источник изображения: Nvidia Необходимо отметить, что производительность ускорителей ИИ измерялась с использованием фреймворка PyTorch, а в случае применения оптимизации TensorRT чипы A100 создают изображения до 40 % быстрее, чем Gaudi2. Тем не менее, исследователи Stability AI ожидают, что при дальнейшей оптимизации Gaudi2 превзойдёт A100. Компания полагает, что более быстрый интерконнект и больший объем памяти (96 Гбайт) делают решения Intel вполне конкурентоспособными и планирует использовать ускорители Gaudi2 в Stability Cloud.

Источник изображения: techpowerup.com По сообщению Stability AI, в более ранних тестах модели Stable Diffusion XL с использованием фреймворка PyTorch ускоритель Intel Gaudi2 генерирует при 30 шагах изображение размером 1024 × 1024 за 3,2 секунды по сравнению с 3,6 секунды для PyTorch на Nvidia A100 и 2,7 секунды при использовании оптимизации TensorRT на Nvidia А100. NVIDIA запустила девятый по мощности суперкомпьютер в мире — Eos получил 4608 ИИ-ускорителей H100

17.02.2024 [13:07],

Павел Котов

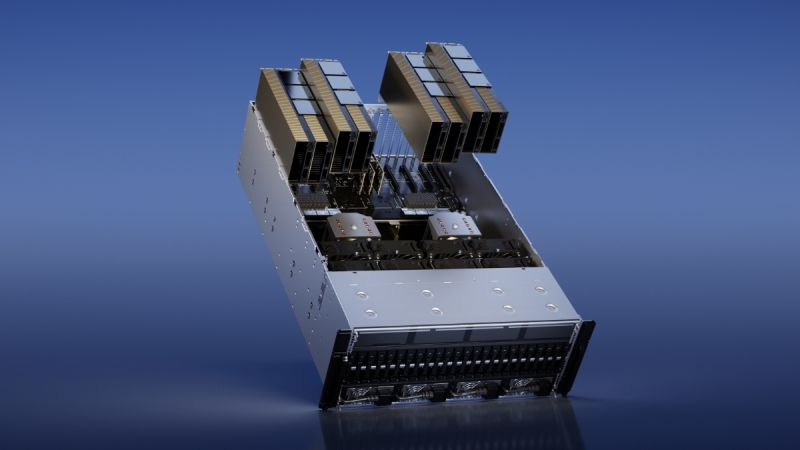

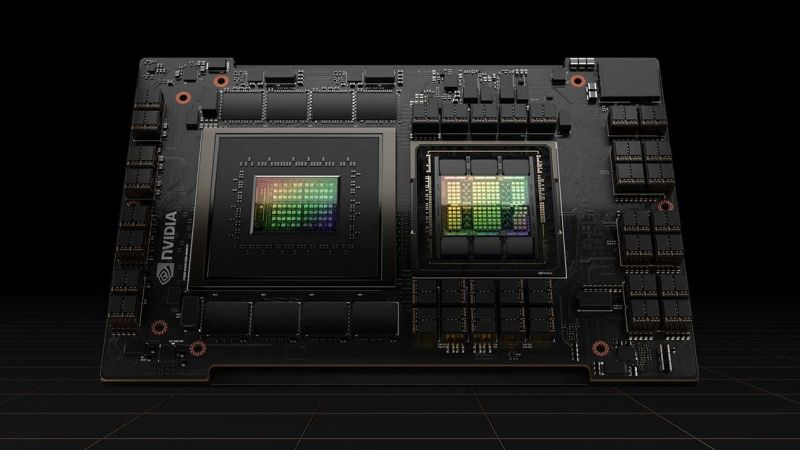

NVIDIA официально представила суперкомпьютер Eos, предназначенный для приложений искусственного интеллекта. Он оснащён 576 системами NVIDIA DGX H100, каждая из которых включает 8 ускорителей H100 — всего 4608 единиц. Системы подключены с использованием архитектуры NVIDIA Quantum-2 InfiniBand (400 Гбит/с). Также суперкомпьютер включает 1152 процессора Intel Xeon Platinum 8480C, каждый из которых предлагает 56 ядер.

Источник изображения: nvidia.com Суперкомпьютер NVIDIA Eos предлагает производительность для ИИ-приложений в 18,4 Эфлопс (FP8), а также обеспечит около 9 Эфлопс в рассчётах FP16 и 275 Пфлопс в FP64. Компания анонсировала его почти год назад и рассказывала подробнее о нём на выставке Supercomputing 2023 в ноябре минувшего года — теперь он готов начать работу. Разработчик отмечает, что Eos способен справиться с самыми большими рабочими нагрузками в области ИИ для обучения больших языковых моделей, рекомендательных алгоритмов, квантового моделирования и многого другого. Суперкомпьютер занимает девятое место в рейтинге TOP500. Высокую производительность NVIDIA Eos обеспечивают мощные ускорители и интерфейсы компании NVIDIA, а также её ПО, такое как NVIDIA Base Command и NVIDIA AI Enterprise. «Архитектура Eos оптимизирована для рабочих нагрузок ИИ, требующих сверхмалой задержки и высокой пропускной способности соединений внутри кластера ускорителей, что делает её идеальным решением для предприятий, стремящихся масштабировать свои комплексы ИИ. В то время как корпорации и разработчики по всему миру стремятся задействовать возможности ИИ, Eos становится основным ресурсом, который обещает ускорить путь к приложениям на базе ИИ для каждой организации», — отметила NVIDIA. AMD опровергла опровержение NVIDIA — ИИ-ускоритель MI300X на 30 % быстрее NVIDIA H100, даже с оптимизациями

16.12.2023 [13:58],

Николай Хижняк

Компания AMD ответила на недавнее заявление NVIDIA о том, что ускорители вычислений NVIDIA H100, при использовании оптимизированных библиотек TensorRT-LLM для ИИ-расчётов, быстрее справляются с поставленными задачами, чем новые ускорители AMD Instinct MI300X. По мнению AMD, её ускорители всё равно выигрывают.

Источник изображения: Wccftech Двумя днями ранее компания NVIDIA опубликовала свои результаты тестов специализированных ускорителей вычислений Hopper H100 и заявила, что они значительно быстрее новейших ИИ-ускорителей AMD MI300X, которые были представлены на мероприятии Advancing AI на прошлой неделе. По словам NVIDIA, AMD при сравнении своих MI300X с H100 не использовала для последних специальные оптимизированные программные библиотеки TensorRT-LLM, которые повышают эффективность ИИ-чипов NIVDIA. NVIDIA опубликовала данные своих тестов с использованием библиотек TensorRT-LLM, которые показали практически 50-процентное преимущество над ускорителями AMD MI300X. AMD решила ответить на это заявление, показав на новых графиках, как MI300X по-прежнему оказывается быстрее ускорителей H100, даже если последние используют оптимизированный под них стек программного обеспечения. По словам AMD, свои данные NVIDIA приводит:

Согласно новым тестам AMD, её ускорители MI300X, работающие с библиотеками vLLM, на 30 % производительнее ускорителей NVIDIA H100, даже если последние работают с библиотеками TensorRT-LLM. Ниже показан новый график результатов тестов ускорителей H100 и MI300X, предоставленный AMD. Ниже приведено заявление AMD.

Публичный спор между AMD и NVIDIA в очередной раз демонстрирует, что в сегменте ИИ-вычислений наблюдается очень высокая конкуренция между производителями аппаратного обеспечения, которые готовы бороться за каждого клиента. NVIDIA развенчала миф от AMD: ИИ-ускорители H100 в реальных задачах в разы быстрее Instinct MI300X

14.12.2023 [21:13],

Николай Хижняк

Компания NVIDIA опубликовала свежие данные о производительности своих ИИ-ускорителей H100, сравнив их с недавно представленными ускорителями Instinct MI300X от компании AMD. Этим сравнением NVIDIA решила показать, что на самом деле H100 обеспечивают более высокую производительность по сравнению с конкурентом, если использовать правильную программную среду для ИИ-вычислений. Компания AMD этого не учла в своём сравнении ускорителей, посчитали в NVIDIA.

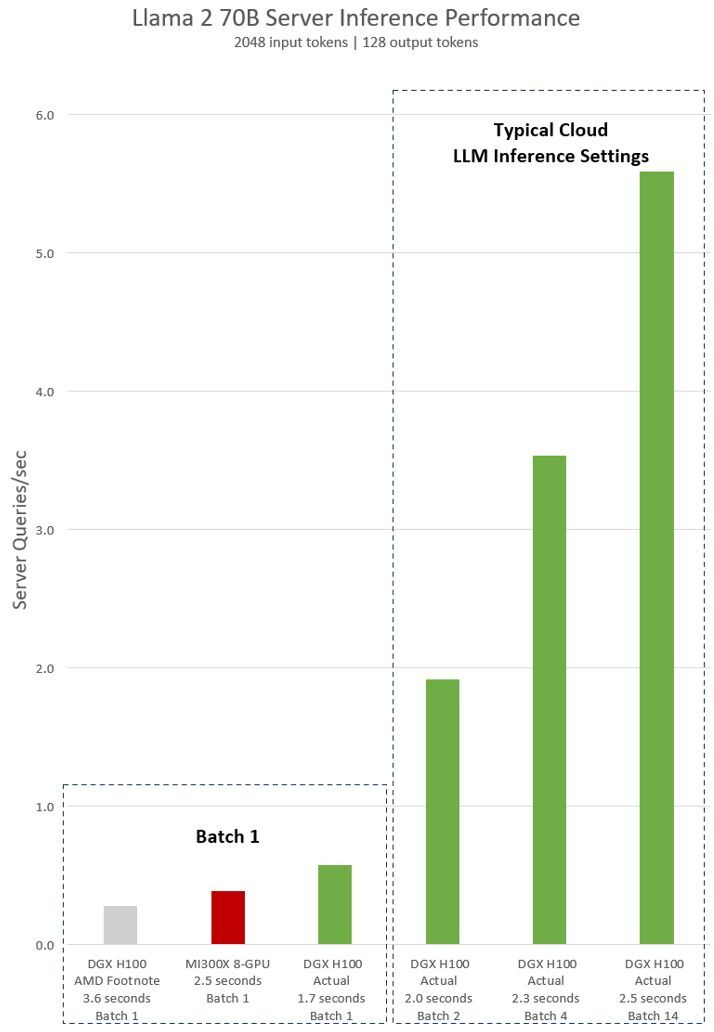

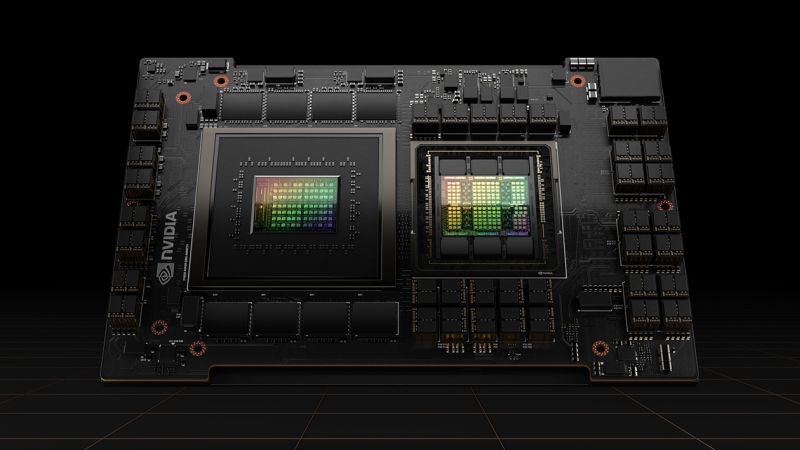

Источник изображения: Wccftech Во время презентации Advancing AI компания AMD официально представила специализированные ускорители вычислений для ИИ Instinct MI300X и сравнила их в различных бенчмарках и тестах с ускорителями H100 от NVIDIA. В частности, AMD заявила, что один ускоритель MI300X обеспечивает на 20 % более высокую производительность по сравнению с одним ускорителем H100, а сервер из восьми MI300X до 60 % быстрее сервера из восьми H100. NVIDIA опубликовала заметку на своём сайте, в которой утверждает, что эти заявления далеки от правды. Ускорители вычислений NVIDIA H100 были выпущены в 2022 году и с тех пор получили различные улучшения на уровне программного обеспечения. Например, наиболее свежие улучшения, связанные с программной средой для ИИ-вычислений TensorRT-LLM позволили ещё больше повысить производительность H100 в рабочих нагрузках, специфичных для искусственного интеллекта, а также провести оптимизацию на уровне ядра. Всё это, по словам NVIDIA, позволяет чипам H100 эффективнее работать с такими большими языковыми моделями, как Llama 2 с 70 млрд параметров с использованием операций FP8. Сама AMD в своей презентации утверждала, что Instinct MI300X до 20 % быстрее H100 в Llama 2 70B, а также система из восьми ускорителей AMD обеспечивает превосходство по задержке на 40 % по сравнению с системой на восьми NVIDIA H100 в той же нейросети. Превосходство в операциях FP8 и FP16 составляет 30 % в пользу MI300X. AMD проводила тесты своих ускорителей MI300X с использованием оптимизированных библиотек программной среды вычислений ROCm 6.0. Однако для NVIDIA H100 использовались данные без учёта применения оптимизированной программной среды TensorRT-LLM, предназначенной для этих задач. В свежей статье NVIDIA привела актуальные данные производительности одного DGX-сервера из восьми H100 в модели Llama 2 70B с учётом обработки одного программного пакета (Batch-1).

Источник изображения: NVIDIA NVIDIA поясняет, что выводы AMD (серым и красным на графике выше) о превосходстве над H100 основаны на данных, представленных в сноске #MI300-38 к презентации AMD. Для их получения использовалась система NVIDIA DGX H100, фреймворк vLLM v.02.2.2 и модель Llama 2 70B с длиной входной последовательности 2048 и длиной выходной последовательности 128. NVIDIA отмечает, что в AMD сравнили систему из восьми MI300X с системой DGX H100 из восьми H100. В свою очередь данные NVIDIA показаны на графике зелёным. Для их получения применена система DGX H100 из восьми NVIDIA H100 с 80 Гбайт памяти HBM3 в каждом, а также находящийся в открытом доступе фреймворк NVIDIA TensorRT-LLM v0.5.0 для расчёта Batch-1 и версии v0.6.1 для расчёта задержки. Рабочая нагрузка такая же, как указано в сноске AMD #MI300-38. Приведённые NVIDIA результаты показывают, что сервер DGX H100 вдвое быстрее при использовании оптимизированных фреймворков, чем заявляет AMD. Кроме того, сервер с восемью H100 до 47 % быстрее системы с восемью AMD MI300X. «Система DGX H100 способна обработать один инференс-запрос размером в один пакет (Batch-1) или иными словами, один запрос вывода за раз, за 1,7 секунды. Запрос уровня Batch-1 обеспечивает максимально быстрый показатель времени отклика для обработки модели. Для оптимизации времени отклика и пропускной способности ЦОД облачные сервисы устанавливают фиксированное время ответа для конкретной задачи. Это позволяет операторам ЦОД объединять несколько запросов на вывод в более крупные “пакеты” и увеличивать общее количество выводов сервера в секунду. Стандартные отраслевые тесты вроде MLPerf также измеряют производительность с помощью этого фиксированного показателя времени отклика», — продолжает NVIDIA. В NVIDIA поясняют, что небольшие компромиссы в вопросе времени отклика системы могут привести к увеличению количества запросов на вывод, которые сервер может обработать в реальном времени. Используя фиксированный бюджет времени отклика в 2,5 секунды, сервер DGX H100 с восемью графическими процессорами может обработать более пяти инференс-запросов Llama 2 70B за раз. NVIDIA отгрузила 900 тонн ускорителей H100 в прошлом квартале

17.09.2023 [07:10],

Алексей Разин

Объёмы поставок ускорителей NVIDIA для систем искусственного интеллекта в новостях фигурируют преимущественно в контексте обсуждения дефицита данного вида компонентов, но представители Omdia использовали неожиданный подход для оценки масштабов отгрузки этой продукции NVIDIA — за второй квартал, по их мнению, компания поставила клиентам не менее 900 тонн ускорителей H100.

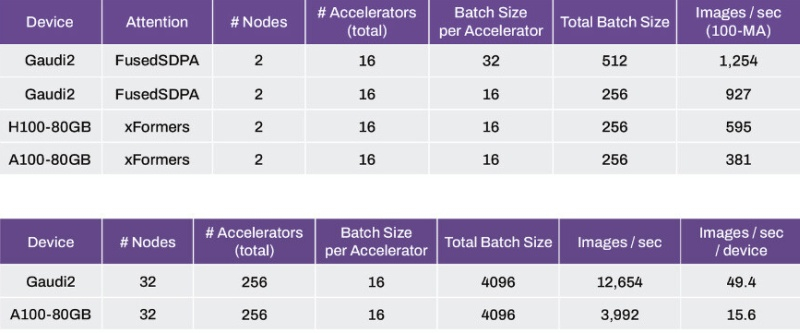

Источник изображения: NVIDIA Как поясняет ресурс Tom’s Hardware, данный показатель увязывается авторами исходной оценки со способностью NVIDIA отгрузить по итогам второго квартала около 300 000 ускорителей H100. Средняя масса такого изделия в сочетании с системой охлаждения достигает 3 кг, по данным первоисточника, что и даёт в итоге 900 тонн. Следует учитывать, что на базе чипов H100 создаются ускорители разных типоразмеров. Плата с разъёмом PCI Express весит 1,2 кг, но масса модуля SXM в открытых источниках не фигурирует, и лишь по приблизительным оценкам можно судить, что она наверняка приближается к 2 кг. На недавней технологической конференции финансовый директор компании Колетт Кресс (Colette Kress) призналась, что во втором квартале NVIDIA отгрузила примерно равное количество ускорителей H100 и A100, поэтому в массовом выражении последних было выпущено тоже около 900 тонн, если ориентироваться на оценки Omdia. Существуют ещё и адаптированные под условия антикитайских санкций США ускорители A800 и H800, которые не должны отличаться по массе от исходных A100 и H100, но пока сложно судить, учитывались ли они в этой статистике. Представители NVIDIA не раз за последние недели подчеркнули, что с каждым кварталом компания будет увеличивать объёмы поставок ускорителей, и темпы этой экспансии сейчас во многом зависят от способности подрядчиков выпускать необходимое количество профильной продукции. «Узким местом», например, многими экспертами считается этап тестирования и упаковки чипов силами компании TSMC. С учётом некоторого количества поставленных в первом квартале ускорителей вычислений, по итогам всего года NVIDIA наверняка выпустит более 1 млн одних только H100. Сейчас данный вид деятельности является источником основных доходов для NVIDIA, поэтому она заинтересована в максимально быстрой экспансии. Tesla запустила суперкомпьютер на 10 тыс. ускорителей NVIDIA H100 — на нём будут учить автопилот

30.08.2023 [21:06],

Николай Хижняк

Компания Tesla сообщила о запуске на этой неделе нового суперкомпьютера для решения ресурсоемких задач, связанных с ИИ. В его основе используются 10 тыс. специализированных графических ускорителей NVIDIA H100.

Источник изображений: HPC Wire Отмечается, что система обеспечивает пиковую производительность в 340 Пфлопс в операциях FP64 для технических вычислений и 39,58 Эфлопс в операциях INT8 для задач ИИ. Таким образом, по производительности FP64 кластер превосходит суперкомпьютер Leonardo, который располагается на четвёртой позиции в нынешнем мировом рейтинге суперкомпьютеров Тор500 с показателем 304 Пфлопс. Новый суперкомпьютер Tesla с ускорителями NVIDIA H100 является одной из самых мощных платформ в мире. На формирование кластера потрачено около $300 млн. Он подходит не только для обработки алгоритмов ИИ, но и для НРС-задач. Благодаря данной системе компания рассчитывает значительно расширить ресурсы для создания полноценного автопилота. На фоне сформировавшегося дефицита ускорителей NVIDIA H100 компания хочет диверсифицировать вычислительные мощности. Для этого Tesla ведёт разработку своего собственного проприетарного суперкомпьютера Dojo. В проект планируется инвестировать $1 млрд. Уже к октябрю следующего года Tesla рассчитывает преодолеть барьер в 100 Эфлопс производительности, что более чем в 60 раз мощнее самого производительного суперкомпьютера в мире на сегодняшний день. Помимо простого аппаратного обеспечения, новая вычислительная инфраструктура предоставит Tesla преимущество в обработке огромных наборов данных, что имеет решающее значение для реальных сценариев обучения ИИ. Очередь за ускорителями вычислений NVIDIA H100 растянулась до 2024 года

10.08.2023 [10:26],

Алексей Разин

Ажиотажный спрос на ускорители вычислений NVIDIA для систем искусственного интеллекта уже привёл к дефициту данного вида продукции, и старшая карта H100 с архитектурой Hopper востребована в такой степени, что все доступные объёмы таких ускорителей уже распределены до начала следующего года.

Источник изображения: NVIDIA По крайней мере, уверенность в этом в интервью ресурсу Barron’s выразил технический директор стартапа CoreWeave Брайан Вентуро (Brian Venturo), поскольку приближённый к NVIDIA поставщик инфраструктурных решений для ускорения вычислений силами GPU имеет актуальное представление о положении дел на рынке. Как пояснил Брайан Вентуро, ещё в первом квартале текущего года с доступом к нужным объёмам ускорителей проблем не было, но в апреле всё резко изменилось. Сроки исполнения заказов растянулись до конца текущего года, и спрос неожиданно подскочил буквально за одну неделю. Ускорители теперь нужны не только крупным облачным провайдерам, но и исследовательским лабораториям, и крупным предприятиям, которые экспериментируют с внедрением систем искусственного интеллекта. Как поясняет этот поставщик ускорителей, сейчас желающие получить самую производительную версию в исполнении NVIDIA, которая обозначается H100, вынуждены рассчитывать сроки поставки на первый или второй квартал следующего года. Непосредственно CoreWeave, инвестором которой является сама NVIDIA, сможет возобновить закупку ускорителей серии H100 не ранее второго или третьего квартала следующего года. По словам руководителя компании, решения NVIDIA в этой сфере востребованы в силу наличия развитой экосистемы для разработчиков, универсальности и сопутствующей инфраструктуры передачи информации в виде скоростных решений InfiniBand. Двойная цена и малые партии: ускорители вычислений NVIDIA можно купить в Китае даже в условиях санкций

20.06.2023 [06:46],

Алексей Разин

С осени прошлого года ускорители вычислений NVIDIA A100 и H100 попали под экспортные ограничения США, в результате чего их стало невозможно купить в Китае по официальным каналам, а NVIDIA пришлось быстро наладить поставки в страну усечённых по производительности ускорителей A800 и H800, которые соответствуют экспортным ограничениям США. Практика показывает, что ускорители A100 и H100 всё равно можно приобрести в Китае, хотя и не на самых выгодных условиях.

Источник изображения: NVIDIA Корреспондентам Reuters удалось побывать на крупном рынке электроники в китайском Шэньчжэне, и по итогам краткого опроса местных продавцов не менее десяти из них предложили потенциальным покупателям ускорители NVIDIA A100 по удвоенной до $20 000 за штуку цене. Кроме того, покупатель в Китае не может рассчитывать на единовременное получение крупной партии таких ускорителей, речь обычно идёт о поставке буквально нескольких экземпляров за раз. Как поясняют участники цепочки поставок, на китайский рынок попавшие под санкции США ускорители NVIDIA продолжают поставляться либо через посредников в Индии, Сингапуре или на Тайване, либо по «серым» каналам из США, в случае, если какой-то из крупных клиентов NVIDIA просто выбросит на рынок «излишки» заказанных для собственных нужд ускорителей. Подчёркивается, что китайские продавцы не дают никакой гарантийной поддержки для реализуемых по такой схеме ускорителей вычислений. Поставки ускорителей NVIDIA H100 начались только в марте, поэтому в Китае их найти достаточно сложно, и предложений пока мало. Запрещённые к реализации в КНР ускорители NVIDIA встречаются и на популярных в стране торговых интернет-площадках, но ситуацией нередко пользуются и мошенники, продающие откровенные подделки. По мнению аналитиков 86Research, власти США пока не сильно обеспокоены сохранением поставок ускорителей NVIDIA в Китай мелкими партиями, поскольку они стремятся отрезать к ним доступ для крупных разработчиков. Необходимость платить двойную цену за санкционную продукцию NVIDIA не будет сохраняться в Китае вечно, поскольку некоторое количество китайских стартапов будет вынуждено уйти с рынка, и спрос автоматически снизится. NVIDIA снова в выигрыше: ИИ-бум поднял цены на ускорители H100 до $40 000

15.04.2023 [00:36],

Николай Хижняк

Из-за стремительного роста спроса на аппаратное обеспечение, необходимое для обучения и развёртывания технологий искусственного интеллекта, передовые ускорители вычислений NVIDIA H100 продаются на торговой онлайн-площадке eBay более чем за $40 тыс.

Источник изображения: NVIDIA На ситуацию обратил внимание пионер игровой индустрии и бывший технологический консультант компании Meta✴ Джон Кармак (John Carmack). В пятницу как минимум восемь ускорителей NVIDIA H100 предлагалась продавцами на eBay по ценам от $39,995 до почти $46 000. Немного ранее некоторые продавцы отпускали их по $36 000 за штуку. Флагманский ускоритель вычислений H100, являющийся наследником модели A100 стоимостью $10 тыс., был представлен NVIDIA в прошлом году. Разработчики используют H100 для создания так называемых языковых моделей (LLM), являющихся основной для таких ИИ-приложений, как чат-бот ChatGPT от компании OpenAI. Это очень дорогие и энергозатратные системы, способные всего за несколько дней или недель обрабатывать терабайты информации, необходимой для обучения ИИ. Процесс обучения ИИ-моделей, особенно таких больших как GPT, требует одновременной работы сотен передовых ускорителей NVIDIA. Та же компания Microsoft потратила сотни миллионов долларов на закупку десятков тысяч ускорителей NVIDIA A100 предыдущего поколения, на базе которых проводилось обучение чат-бота ChatGPT для OpenAI. В ассортименте компании NVIDIA также есть готовые суперкомьютеры DGX, в состав которых входят сразу по восемь ускорителей вычислений. В этом году компания запустила облачный сервис DGX Cloud, позволяющий арендовать доступ к системам DGX A100 за $37 тыс. в месяц. NVIDIA выпустила специально для Китая ускоритель H800 — аналог Hopper H100, который избегает санкций

22.03.2023 [10:21],

Алексей Разин

Когда осенью прошлого года американские власти сформулировали ограничения по производительности ускорителей вычислений, поставляемых в Китай, компания NVIDIA достаточно быстро выпустила на местный рынок специальный чип A800, который являлся аналогом полноценного A100, но предусматривал ограничение по скорости передачи информации. Теперь очередь дошла и до архитектуры Hopper — китайским клиентам NVIDIA предложила ускорители H800.

NVIDIA H100 в одном из вариантов исполнения. Источник изображения: NVIDIA Что именно ограничено на уровне характеристик относительно H100, агентство Reuters не уточняет, но даёт понять, что главным критерием снова стала скорость передачи информации. Осенью были запрещены поставки в Китай ускорителей вычислений NVIDIA, по своей производительности соответствующих A100 и H100, причём в последнем случае сама NVIDIA сохраняет право отгружать их китайским клиентам до сентября текущего года. По всей видимости, это не помешало ей заблаговременно представить адаптированный под новые требования ускоритель H800, у которого ограничена скорость передачи информации. По словам представителей NVIDIA, ускорители модели H800 уже используются в центрах обработки данных китайских компаний Alibaba Group, Baidu и Tencent Holdings. По данным китайских источников, скорость передачи данных у H800 снижена примерно в два раза относительно полноценного H100. Сотрудники NVIDIA не стали конкретизировать, в чём заключаются отличия, но пояснили, что «семейство продуктов 800 полностью соответствует требованиям правил в области экспортного контроля». NVIDIA предложила на китайском рынке ускоритель A800, который с запасом избегает санкций

08.11.2022 [06:01],

Алексей Разин

Этой осенью американские власти запретили NVIDIA поставлять в Китай ускорители вычислений с уровнем быстродействия A100 и H100, хотя формально компания сохранила возможность делать это до марта 2023 года в первом случае, и до сентября во втором. Ответом на данные ограничения, по словам Reuters, стал выпуск компанией NVIDIA специально для нужд китайских клиентов нового ускорителя A800, который в полтора раза уступает по быстродействию A100, по этой причине не попадая под санкционные ограничения.

NVIDIA A100. Источник изображения: NVIDIA Как отмечается, китайские поставщики серверного оборудования уже начали рекламировать системы на основе ускорителя A800, который может быть установлен вместо A100 или H100, но при этом поднять уровень быстродействия такого ускорителя сами клиенты за счёт каких-либо манипуляций не смогут. По словам представителей NVIDIA, выпуском A800 компания занялась в третьем квартале, и этот ускоритель является «законной» альтернативой A100 для клиентов в Китае. Согласованы ли данные шаги с американскими регуляторами, не уточняется. На сайте китайских производителей серверного оборудования A800 уже сравнивается по характеристикам с A100, и скорость передачи информации у него снижена с 600 до 400 Гбайт/с. Таким образом, до «санкционной» планки в 600 Гбайт/с остаётся полуторакратный запас, что и даёт NVIDIA право поставлять ускорители A800 в Китай. Когда соответствующие ограничения были объявлены в сентябре, NVIDIA прогнозировала, что может потерять из-за них до $400 млн выручки. В таких условиях создание особого ускорителя для китайского рынка оправдывает себя с материальной точки зрения. Из-за новых антикитайских санкций NVIDIA рискует лишиться $400 млн

01.09.2022 [06:38],

Алексей Разин

Взяв за основу уровень производительности, обеспечиваемый ускорителями вычислений A100, власти США запретили NVIDIA поставлять в Китай и Россию не только их, но и более современные H100. Компания выразила озабоченность не только способностью довести до конца разработку нового поколения ускорителей в намеченные сроки, но и потерей до 10 % выручки на серверном направлении.

Источник изображения: NVIDIA Дело в том, как поясняет Reuters, что NVIDIA уже заключила с китайскими клиентами контракты на поставку ускорителей вычислений из «запрещённой номенклатуры» на общую сумму $400 млн, и если китайские компании не переключатся на альтернативные изделия марки, которые не попали под новые ограничения, то пропорциональная часть выручки в третьем квартале может быть потеряна. NVIDIA выразила готовность подать заявку на оформление экспортной лицензии, которая позволила бы ей продолжать поставки ускорителей вычислений в Китай, но она не уверена в успехе данной затеи. С точки зрения распространения данных ограничений на поставки ускорителей в Россию влияние на бизнес NVIDIA вряд ли будет значительным. Во-первых, компания ещё весной прекратила официальные поставки своей продукции на российский рынок. Во-вторых, она пояснила, что в совокупной структуре выручки наша страна формировала не более двух процентов, и только в игровом сегменте российские клиенты обеспечивали её четырьмя процентами выручки. По всей видимости, в серверном сегменте зависимость NVIDIA от российского рынка была выражена ещё слабее. Примечательно, что опубликованная вчера же форма квартального отчёта 10-Q компании NVIDIA демонстрирует её высокую зависимость от китайского рынка в целом. Например, в минувшем квартале она выручила здесь почти 24 % от совокупной суммы $6,7 млрд. Если учесть, что в текущем квартале компания рассчитывает выручить на всех рынках присутствия не более $5,9 млрд, то потеря $400 млн на китайском направлении станет для неё серьёзным ударом. Эти новости вызвали снижение курса акций компании на 6,56 %. SK hynix начала массовое производство памяти HBM3 — первым продуктом с ней будут серверные ускорители NVIDIA H100

09.06.2022 [17:38],

Николай Хижняк

Компания SK hynix сообщила о начале массового производства памяти HBM3. Первыми коммерческими продуктами с её использованием станут серверные ускорители вычислений NVIDIA H100 на графической архитектуре Hopper.

Источник изображения: SK hynix В SK hynix отмечают, что к массовому производству памяти HBM3 производитель перешёл спустя всего семь месяцев с момента первого официального анонса данного стандарта памяти в октябре прошлого года. Использование памяти HBM3 в коммерческих продуктах позволит значительно увеличить производительность в задачах, связанных с искусственным интеллектом и большими данными. Компания NVIDIA недавно завершила тестирование образцов памяти SK hynix HBM3. Поставки систем NVIDIA с этим видом памяти начнутся в третьем квартале текущего года. SK hynix увеличит объёмы производства памяти HBM3 в соответствии с запросами NVIDIA. Память SK hynix HBM3 обеспечивает пропускную способностью до 819 Гбайт/с. Это равносильно передаче 163 фильмов в разрешении 1080p (размер файла 5 Гбайт) каждую секунду. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |