⇣ Содержание

|

Опрос

|

реклама

Самое интересное в новостях

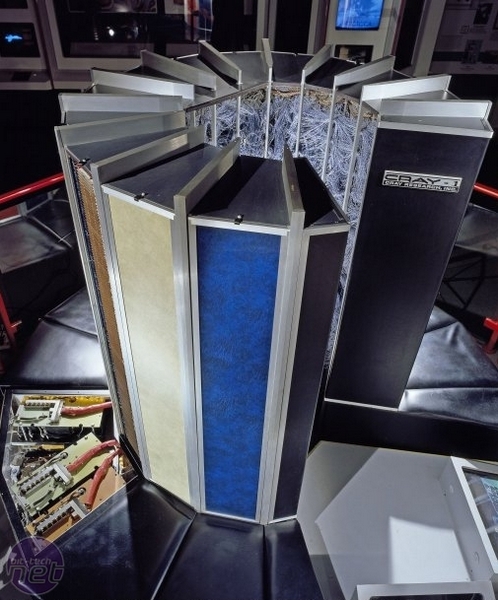

К точке критического перехода

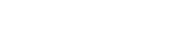

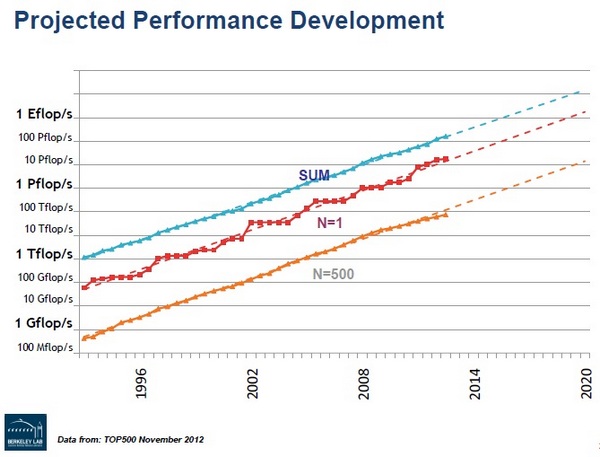

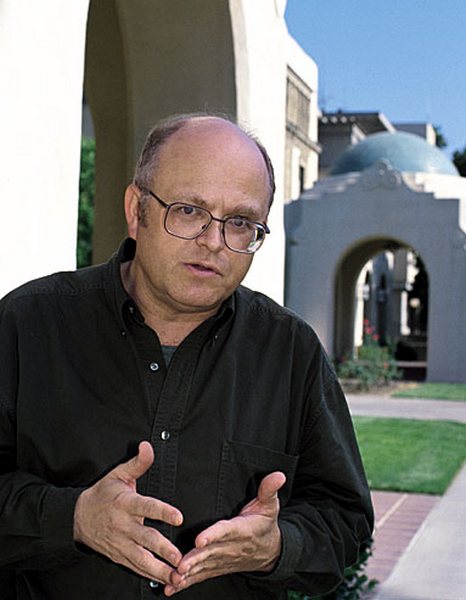

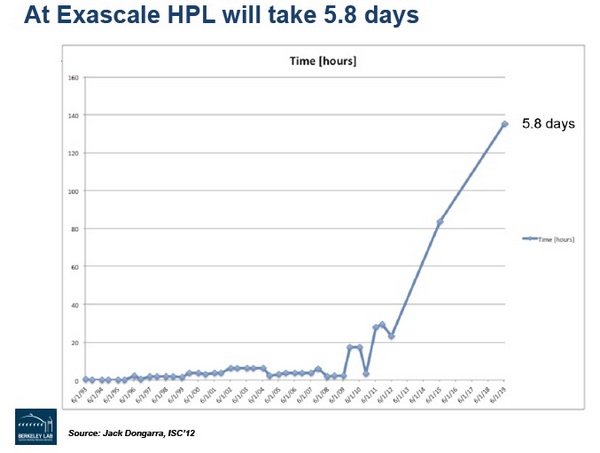

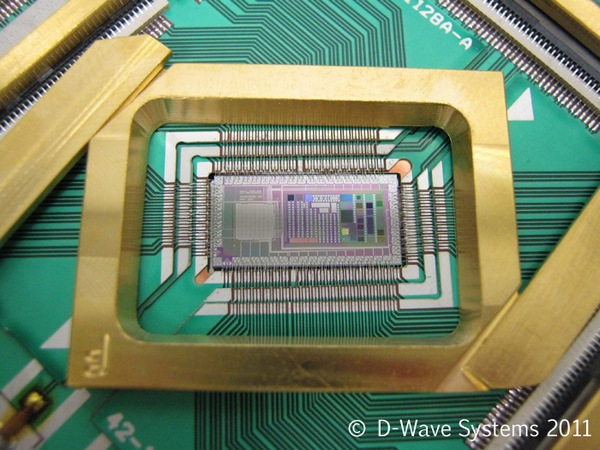

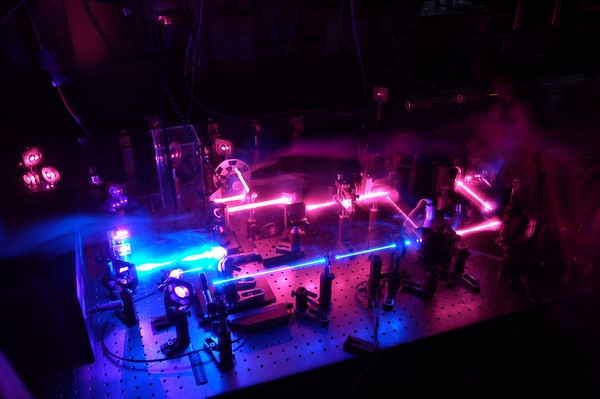

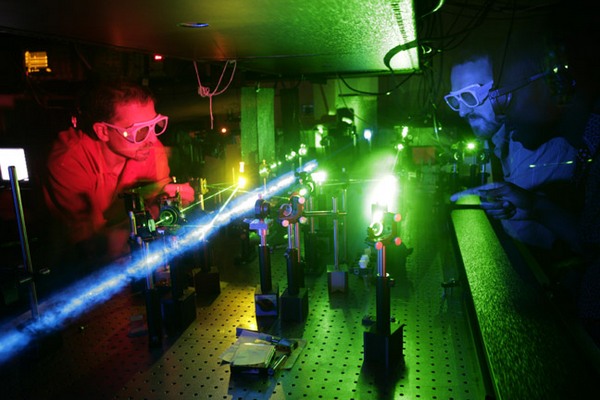

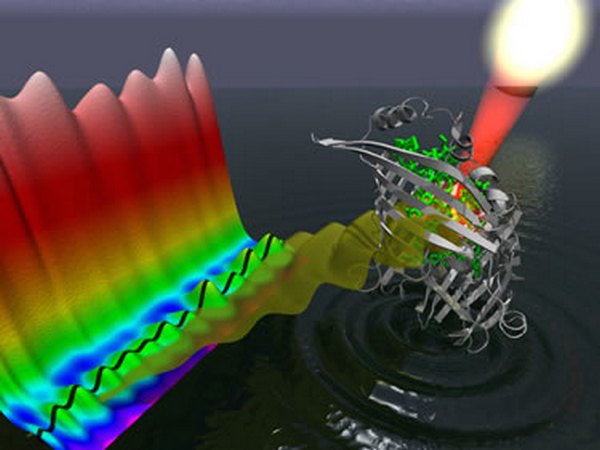

Каждый год в середине июня германский город Лейпциг принимает у себя главный форум всемирного суперкомпьютерного сообщества — International сomputer Conference 2013. По давно заведенной традиции в рамках этого мероприятия оглашается TOP500, то есть рейтинговый список полутысячи самых быстрых и мощных вычислительных систем планеты. Понятно, наверное, что суперкомпьютеры, занимающие самые престижные верхние строчки в TOP500, — это не только предмет особой гордости государств, владеющих столь ценными хайтек-ресурсами, но еще и своеобразное зеркало, которое отражает самые передовые тенденции в области высокопроизводительных вычислений, или, кратко, HPC (High Performance Computing). Соответственно, ту небольшую группу людей, которым сообщество доверило работу по ежегодному составлению и редактированию списка TOP500, принято расценивать как наиболее компетентных и знающих специалистов в сфере HPC. Опять-таки по давней традиции соредакторами TOP500 являются четыре человека — два из Америки и два из Европы (в обозримом будущем, естественно, появятся и представители Азии, но пока этого нет). И неудивительно, что когда кто-то из редакторов TOP500 выступает с докладом о положении и тенденциях в отрасли, к его словам принято внимательно прислушиваться. Удивительным же тут является вот что: примерно за месяц до начала ISC'13, в мае 2013-го, один из соредакторов TOP500 с американской стороны, Хорст Саймон (Horst Simon) два раза подряд выступил на конференциях помельче с одним и тем же, по сути, программным докладом, озаглавленным подчеркнуто вызывающе: «Вычисления экза-масштаба и почему мы их не получим к 2020 году» (интервью на ту же тему). Дабы вся необычность этого заявления стала понятнее для неспециалистов, можно пояснить два ключевых момента. Во-первых, на протяжении всей истории суперкомпьютеров рост производительности машин происходил с соблюдением (а иногда и некоторым опережением) известного закона Мура, согласно которому быстродействие вычислений повышается в 1000 раз примерно каждые 10-11 лет. Во-вторых, психологически важный петафлопсный рубеж (1 петафлопс = 1015 операций с плавающей запятой в секунду) был преодолен — как и планировалось — в 2008. Поэтому вполне естественно, что в суперкомпьютерном сообществе фактически по умолчанию уже принято рассматривать 2018-2019 годы как выход на следующий, экзафлопсный уровень вычислений (1 экзафлопс = 1018 операций).  Рост производительности суперкомпьютеров и прогноз на будущее. Желтый цвет-машина на последнем месте в TOP500, красный-машина #1, голубой-суммарная производительность всех систем в TOP500. И тут вдруг поднимается солидный, всеми уважаемый научный авторитет Хорст Саймон (ныне заместитель директора LBNL, Национальной лаборатории им. Лоуренса в Беркли, известной, среди всего прочего, как один из главных суперкомпьютерных центров США) и ответственно заявляет, что никаких экзафлопсов, скорее всего, у человечества на этот раз не будет. Ни к 2018-му, ни даже к 2020 году... Если же принять во внимание, что ровно год назад, в мае 2012-го, другой весьма известный в суперкомпьютерном мире специалист из США, Томас Стерлинг (Thomas Sterling), также выступал с очень похожими по духу и выводам заявлениями, то явно имеет смысл прислушаться — о чем конкретно тут идет речь. Ну а поскольку соображения и прогнозы второго эксперта прозвучали годом ранее, начать логичнее именно с него. ⇡#Предел СтерлингаШирокой компьютерной публике Томас Стерлинг известен, в первую очередь, как отец популярной кластерной архитектуры Beowulf и как один из разработчиков первых петафлопсных систем. Или, иначе, как компетентный специалист, продуктивно занимающийся суперкомпьютерами вот уже более 30 лет. Здесь же к месту будет отметить, что и вся история суперкомпьютеров насчитывает чуть больше трех десятилетий. При этом, благодаря стремительным темпам прогресса, на три порядка повышавшего производительность машин каждое десятилетие, бытовой лексикон людей стал регулярно пополняться новыми «суперкомпьютерными» терминами.  Когда на рубеже 80-90-х годов для частоты процессора или байтов памяти накопителей только-только начали входить в обиход слова с префиксом «гига-» (обозначающим миллиард, или 109), у конструкторов суперкомпьютеров, замышлявших покорение следующего рубежа производительности, уже имелся соответствующий термин «тера-» для масштаба триллионов (1012) операций. И когда к 1999 году в США была создана первая в истории компьютерная система, достигшая рекордной производительности 1 терафлопс, все чаще стал звучать термин «пета-» — как ориентир на следующий уровень быстродействия порядка квадриллиона (1015) операций в секунду. К 2008 году, когда петафлопсный рубеж удалось преодолеть, соответствующий лексикон для будущих достижений суперкомпьютинга расширился очень значительно. После одного экзафлопса, или квинтиллиона (1018) операций в секунду, запланированного к достижению на 2019 год, уже наметили компьютер производительностью один зеттафлопс (1021, или секстиллион операций) — примерно к 2030 году. А кроме того, заранее запаслись терминами и для последующих вычислительных рубежей — йоттафлопс (1024) и ксерафлопс (1027). Проблема тут, однако, в том, что двигать прогресс супервычислений оказывается несоизмеримо сложнее, чем пачками придумывать новые термины.  И один из самых первых сигналов такого рода подал Томас Стерлинг. В своих публичных выступлениях весной и летом 2012-го он предупредил коллег по цеху, что ожидаемый уже в близком будущем переход к уровню экзафлопсных вычислений на самом деле будет выглядеть существенно иначе, нежели два предыдущих (тера- и пета-) перехода. Причем отличия эти имеют принципиальный характер. Стерлинг напомнил, что в начале 1990-х годов в компьютерной области произошла революция, одновременно предоставившая конструкторам дешевую DRAM-память, быстрые микропроцессоры, технологии объединения чипов в кластеры и тому подобные новые вещи. Стратегия на объединение всех этих прорывов в суперкомпьютинге оказалась в высшей степени успешной и работала несколько десятилетий. Однако ныне та же самая стратегия уже не способна обеспечить переход к вычислениям экзафлопсного масштаба. Не получится это по той причине, поясняет Стерлинг, что средства и методы, прежде работавшие при данном подходе для повышения производительности, теперь уже не могут считаться адекватными. Потому что решение задач экзафлопсного масштаба подразумевает одновременное применение сотен миллионов процессоров, в которых параллельные вычисления предполагаются по миллиарду с лишним каналов. При такой сложности и громоздкости архитектуры эволюционные улучшения уже не работают, а революционных новаций в том же русле никем не предложено. Иначе говоря, суперкомпьютинг ныне подходит к порогу следующего «фазового перехода» — и в делах программирования высокопроизводительных систем, и в вопросах проектирования их архитектуры, и в подходах к общему обеспечению их функционирования. Стерлингом проанализированы все стороны этой огромной проблемы. Но дабы не вдаваться в малопонятную для неспециалистов техническую аргументацию, достаточно проиллюстрировать масштаб трудностей лишь одним примером — чудовищными энергетическими затратами на супервычисления.  По самым грубым прикидкам, на 10 петафлопс производительности ныне затрачивается порядка 10 мегаватт электроэнергии. Этого количества достаточно для питания, к примеру, 4-5 здоровенных торговых центров вроде тех, что ныне строят в пригородах мегаполисов. При типичных тарифах на электроэнергию порядка 10 центов за киловатт это составляет 1 000 долларов в час, или без малого 10 миллионов долларов в год (не считая стоимости охлаждения и обслуживания). Ну а дальше еще хуже — если грядущая система экзафлопсного масштаба будет создаваться примерно на тех же конструктивных принципах, что и нынешние петафлопсники, то она станет потреблять уже порядка 2 гигаватт электричества.  Такие цифры, для справки, примерно соответствуют энергии, вырабатываемой ядерной электростанцией среднего размера. Понятно, наверное, что для питания единственного компьютера — пусть даже «супер-супер» быстрого — чрезвычайно сложно признать такой вариант приемлемым... ⇡#Пари СаймонаПереходя от прошлогоднего выступления Стерлинга к нынешнему докладу Саймона, сразу следует отметить, что они последовательно и согласованно дополняют друг друга по всем ключевым позициям. При этом существенно, что хотя и Томас Стерлинг в госструктурах США человек весьма известный (не раз приглашавшийся в качестве консультанта и в Агентство национальной безопасности, и в Пентагон, и в NASA), государственный масштаб, так сказать, Хорста Саймона куда более значителен. Будучи уже признанным экспертом в мировом сообществе компьютерных ученых и прикладной математики, Саймон в середине 1990-х был назначен директором только что созданного NERSC, Национального научно-компьютерного центра энергетических исследований США. Поскольку базой для Центра в 1996 году стала Berkeley Lab, с той же поры началось и сотрудничество ученого с LBNL.  В последующие годы Саймон стал основателем и первым директором Вычислительного исследовательского подразделения Berkeley Lab, а затем и ассоциированным директором Лаборатории по компьютерным наукам. Иначе говоря, во многом благодаря именно ему центр Berkeley Lab сегодня считается общепризнанным в мире лидером в делах, касающихся суперкомпьютерного обеспечения для поддержки научных исследований в самом широком спектре дисциплин. Все эти этапы большого пути вспоминаются здесь для того, чтобы стало понятнее, почему доклад Хорста Саймона — о больших проблемах с прогнозами на близкий экзафлопс — вызвал в суперкомпьютерном сообществе куда более заметный резонанс, чем прошлогодние предупреждения Стерлинга. При этом Саймон — как редактор TOP500 — выбрал и более конкретный способ аргументации, отталкиваясь от тех вычислительных систем-чемпионов, которые на сегодняшний день занимают три самые верхние строчки в рейтинге мощнейших компьютеров планеты. Случилось так, что три этих системы построены на основе трех существенно различающихся архитектур и как бы воплощают в собе главные конкурирующие направления для движения к будущему вычислителю экзамасштаба. Однако, подчеркивает Саймон, слабые стороны каждого из подходов понимаются хорошо, но при этом нет никакой ясности с тем, какая из архитектур способна привести нас к экзафлопсной машине. Каковы же конкретнее эти три разных маршрута? В общепринятой технической терминологии один из этих путей называется «мультиядерным» (multicore path) и построен вокруг самых передовых, хай-энд-процессоров в линейках Intel x86, SPARC и IBM Power 7. Второй путь, под названием «многоядерный/встроенный» (manycore/embedded), ориентирован на множество более простых и относительно маломощных ядер в процессорах для встроенных систем. Наконец, третий подход «GPU/акселератор» (GPU/accelerator path) использует в высшей степени специализированные процессоры из рыночного пространства видеоигр и графических приложений, такие как NVIDIA Fermi, процессор Cell и Intel Xeon Phi (MIC).  В новейшем TOP500 этим подходам соответствуют три системы в высших строчках списка. В частности, Titan, система номер 1 из Национальной лаборатории США Oak Ridge, использует подход «ГПУ/акселератор». Позицию номер 2 занимает система Blue Gene, воплощающая собой «многоядерный/встроенный» подход. Ну а система номер 3, японский компьютер К, использует «мультиядерный» подход на основе процессоров SPARC. Высказывая свое личное мнение эксперта, Саймон дает такие прогнозы относительно дальнейших перспектив для этих конкурентов. Очень похоже, считает он, что «мультиядерный вариант» ведет нас в тупик (что подтверждается недавним решением IBM аннулировать свой контракт на создание системы Blue Waters, мыслившейся как очередное воплощение мультиядерной идеи). Для второй идеи — «многядерных/встроенных» систем — дело идет к тому, что нынешняя машина Blue Gene станет, судя по всему, и последней в этой линии вычислителей. И пока совершенно неясно, появятся ли в будущем другие машины такого рода. Что же касается третьего подхода, «ГПУ/акселераторы», то этот маршрут сегодня развивается наиболее динамично. В частности, корпорация Intel ныне энергично закупает соответствующие технологии, и очень похоже, что там намерены создать полную суперкомпьютерную систему с прицелом на первое место в TOP500. Короче, если говорить о ближайших перспективах, то Хорст Саймон готов биться об заклад, что уже к 2015 году все 10 самых мощных систем в TOP500 будут основаны на архитектуре «ГПУ/акселератор». Вот только экзафлопсную машину на этом пути, увы, просто так — масштабированием системы — уже не построишь...  Многие годы находясь в самом центре нескончаемых гонок конкурентов за первые места в рейтинговом списке, Хорст Саймон, похоже, уже насквозь пропитался азартом этих соревнований. И осознанно или нет, но любые свои прогнозы переводит на язык пари. Так что и здесь, как только Саймон ответственно выдал свой пессимистичный прогноз — что до 2020 года никому не удастся построить машину, которая займет в TOP500 место номер 1 с максимальной скоростью работы свыше экзафлопса — он тут же заключил соответствующее пари с физиком Томасом Липпертом (Thomas Lippert), главой германского суперкомпьютерного центра Julich, и в основе его — заявление Саймона, что человечество не достигнет этой цели к ноябрю 2019-го. Пари заключено на 2 000 доларов или 2 000 евро, и Саймон уверен, что выиграет. Однако тут же подчеркивает, что предпочел бы его проиграть, если кому-то вдруг действительно удастся построить экзафлопсную машину к тому времени... Если же разбираться с тем, откуда эксперт черпает свою уверенность, то сразу надо отметить что экзафлопсная машина — это не одна большая техническая проблема, а скорее целый комплекс тяжелых проблем. Начать можно с того, что даже измерение производительности такой системы — само по себе непростая задача. Прогон стандартного набора тестов LINPACK, с помощью которого ранжируют машины в TOP500, — это и для машин-чемпионов нынешнего петафлопсного масштаба очень непросто. Администрация должна полностью отключить дорогущую машину от текущих задач и заниматься только ее тестированием на протяжении 25-30 часов. Если же говорить о масштабе экзафлопсов, то на аналогичное стандартное LINPACK-тестирование потребуется от пяти до шести дней. Даже с чисто организационной точки зрения решиться на подобное расточительство будет чрезвычайно сложно.  Куда более тяжкий и принципиально важный барьер — это уже упомянутые ранее тотальные проблемы с питанием. Нынешние машины-чемпионы масштабируемы в смысле производительности, однако здания, поставщики энергии и так далее — аналогичным образом не масштабируются. Отмечающаяся ныне тенденция к улучшению эффективности по питанию — это, к сожалению, в действительности сугубо одноразовая выгода, которая появилась в 2010 году благодаря переходу на многоядерные и акселераторные архитектуры. Но эта тенденция не является самоподдерживающейся и не сохранится, если не появится существенно иная, новая технология. Из того же, что имеется, уже выжато все возможное... И это далеко не все. Совершенно ясно, что с ростом производительности перемещение данных будет стоить все больше и больше, нежели операции — флопсы — даже в пределах чипа. Фактически вместе с ростом скорости операций, количество памяти относительно уменьшается, поддаваясь масштабированию намного хуже, чем скорость вычислений. Это представляет собой серьезнейшую проблему, решением которой пока что всерьез никто не занимается. Однако в будущем, к 2018 году и далее, эта проблема будет только усугубляться. Более того, для перехода к вычислениям экзамасштаба, уверен Саймон, настоятельно требуется менять всю нынешнюю парадигму программирования. Потому что нынешние модели вычислений и системы программирования имеют совершенно не те цели. В старой парадигме главным ограничителем производительности была пиковая тактовая частота; флопсы были самой дорогостоящим элементом системы, так что именно они оптимизировались для вычислений; для масштабирования памяти поддерживалось простое соотношение байт на флопс в терминах емкости и пропускной полосы, а в условиях однородных архитектур надежность рассматривалась как проблема аппаратного обеспечения.  В новой парадигме все выглядит иначе. Теперь энергопотребление — это главное конструктивное ограничение для будущих системных архитектур, а значит, в первую очередь необходимо минимизировать перемещение данных. Другое ограничение — масштабирование памяти, когда скорость вычислений возрастает в два раза быстрее, чем емкость памяти или ширина пропускной полосы. В целом архитектурная неоднородность систем будет лишь нарастать, поэтому в аспектах надежности уже не приходится рассчитывать на одну лишь аппаратную защиту. Короче говоря, эта «новая реальность» наиболее мощных суперкомпьютеров фундаментально разрушает нынешнюю парадигму программирования и всю вычислительную экосистему... Цель публичных выступлений Саймона с этими прогнозами-предупреждениями, в общем-то, совершенно понятна. Трезво оценив тенденции и сделав безрадостные выводы о «срыве графика» по достижению экзафлопса, ученый очень бы хотел, чтобы это воспринималось всеми нормально-спокойно и конструктивно. Как, скажем, естественный, но непростой переход к новым рубежам. Но отнюдь не как «катастрофический провал» весьма дорогостоящих научных исследований и разработок. ⇡#Три маршрута в будущееВажно также подчеркнуть, что в выступлениях Хорста Саймона нет ни малейших сомнений, что экзафлопсный рубеж в недалеком будущем все-таки удастся достигнуть. Просто это произойдет, скорее всего, несколько позже, чем ныне принято ожидать. Но вот что будет дальше — на данный счет докладчик аккуратно воздерживается от прогнозов. А потому имеет смысл вновь обратиться к годичной давности выводам Томаса Стерлинга. Этот эксперт считает, что экзафлопсный рубеж — не просто очень сложный для преодоления этап на пути развития суперкомпьютерных технологий, но он же, похоже, окажется и последним. Поскольку крайне маловероятно, что после него удастся продвинуться в будущем к следующему, зеттафлопсному рубежу (1021 операций). Впрочем, Стерлинг тут же уточняет свой столь сильный прогноз: «Выражаясь более аккуратно, мы никогда не достигнем рубежа зеттафлопсов с помощью традиционных дискретных операций с плавающей запятой». В принципе же, он признает, конечно, что далее человечество вполне способно разработать нечто совершенно новое. Возможно, это будет что-то типа квантовых компьютеров, или метафорических компьютеров, или же биологических компьютеров. Но чем бы это ни было, уверен Стерлинг, это будет не тем, чем занимались создатели компьютеров последние семьдесят лет... Здесь еще раз, наверное, следует подчеркнуть, что к мнению этого эксперта стоит прислушаться по той причине, что он достаточно тесно сотрудничает с разведывательными службами, министерством обороны и военно-промышленным комплексом США. То есть именно с теми структурами мощнейшего государства на планете, которые интенсивно занимаются секретными разработками наиболее передовых компьютерных технологий. Иначе говоря, хотя бы вкратце полезно пояснить, что за технологии супервычислений упомянул мимоходом Томас Стерлинг. И почему они представляются особо перспективными. ⇡#Квантовые компьютерыРешение особо сложных математических задач на основе специфических эффектов квантовой физики привлекает активный интерес ученых на протяжении вот уже двадцати лет. Но ощутимого прогресса никак не удается добиться по той причине, что кубиты — квантовые биты — в регистре такого компьютера должны находиться при обработке в когерентном состоянии квантовой сцепленности. А сцепленность — это в высшей степени хрупкое состояние, распадающееся из-за малейших шумов и флуктуаций в системе. Поэтому дальше регистра из десятка кубитов продвинуться разработчикам никак не удается, а для реальной пользы квантового компьютинга нужны регистры размером в сотни, или еще лучше, тысячи кубитов. Но есть интересная новость. Называется она «квантовый компьютер от D-Wave Systems». Эта канадская фирма еще в 2011 году первой вывела на рынок коммерческий квантовый компьютер: собственной секретной конструкции и с длиной рабочего регистра для начала 128 кубитов. Затем каждый год ей удавалось это число удваивать, так что новейшее поколение данной машины, D-Wave Two, уже имеет регистр длиной 512 кубитов.  Понятно, наверное, что в мировом научном сообществе квантового компьютинга этот революционный продукт сразу был встречен, мягко говоря, с недоверием и скептицизмом. Сформулирую чуть иначе: поначалу специалисты сочли, что это блеф и коммерческая афера каких-то нечистоплотных псевдоученых. Ибо современная наука не в состоянии удерживать сцепленными на время вычислительной обработки даже сотню кубитов. И при этом конструкторы D-Wave не предоставили хоть сколько-нибудь убедительных свидетельств того, что в их компьютере вообще задействованы квантовые эффекты. Было так, впрочем, лишь поначалу. С течением же времени обстановка вокруг этой машины стала заметно меняться. Достаточно сказать, что первым покупателем D-Wave One оказалась корпорация Lockheed Martin, один из главных гигантов военно-промышленного комплекса США. А для грамотной работы с новой техникой совместными усилиями LM и Университета Южной Калифорнии (USC) была создана специальная лаборатория.  Весной 2013-го коллективом специалистов этого подразделения совместно с учеными цюрихского ETH был опубликован научный отчет, в котором вполне ответственно заявляется, что (a) компьютер D-Wave действительно работает на основе квантовой физики и (б) реально дает значительный выигрыш относительно традиционных архитектур при решении сложных задач оптимизации. Ну а в мае этого года стало известно, что новейшую, 512-кубитную версию D-Wave на совместных началах закупили корпорация Google и космическое агентство NASA (одна сторона дала миллионы на покупку, а вторая предоставила площади и персонал под сложную криогенную технику в Эймсовском исследовательском центре, Калифорния). Причем куплена дорогая машина была, естественно, отнюдь не экспромтом — как причуда богатых — а после целой серии собственных тестовых испытаний, подтвердивших, что машина реально соответствует спецификациям, заявленным изготовителем.  И дабы хоть как-то прояснилось, в чем заключается хитрость конструкции D-Wave, следует отметить важнейшую техническую особенность этой машины. Конструкторы D-Wave изначально отказались от попыток длительно удерживать массив кубитов в состоянии квантовой сцепленности — считая это безнадежным делом и тупиковым направлением. Вместо этого упор был сделан на куда более надежно освоенный квантовый эффект туннелирования, благодаря которому система кубитов, на краткий момент приведенная в возбужденное когерентное состояние, затем очень быстро и естественным образом переходит к состоянию энергетического минимума. Алгоритмическое программирование для начального состояния этой системы построено таким образом, что ее итоговое физическое состояние минимума — это и есть готовый ответ на поставленную задачу оптимизации. Понятно, что D-Wave — это не универсальный, а специализированный квантовый компьютер, заточенный лишь под вполне определенный класс задач. Однако разработчики машины никогда этого и не скрывали. Скорее даже наоборот, активно подчеркивается, что класс математических задач оптимизации не только очень обширен, но и постоянно расширяется. ⇡#Метафорические и биологические компьютерыСледующие две категории принципиально новых вычислителей существенно отличаются друг от друга, но для каждой из них уже имеются достаточно подробные описания в других местах (про метафорический компьютинг см. здесь, про биологический нанокомпьютер см., к примеру, тут). Поэтому сейчас достаточно ограничиться лишь кратким упоминанием особенностей данных подходов. В основе метафорического компьютинга лежит весьма глубокая идея о том, что за последние десятилетия физика выявила чрезвычайно много аналогий и параллелей между гидродинамикой и нелинейной оптикой. Иначе говоря, огромное множество сложнейших задач, возникающих в физике жидкостей и газов, оказывается возможным быстро решать с помощью моделирования процессов в лазерно-оптических установках. Образно выражаясь, быстродействующая лазерная оптика может выступать в качестве своеобразной «аэродинамической трубы». То есть нехитрой, в сущности, аппаратуры, с помощью которой еще с начала XX века стали экспериментально решать вычислительно неподъемные задачи, коль скоро уравнения гидродинамики допускают масштабирование от небольшой модели до крупного реального образца.  Гигантски возросшие с той поры знания и математический инструментарий ныне позволяют опереться на эту схему как на метафору и переформулировать задачи из физики жидкостей и газов (а также еще большее число задач из смежных областей) на язык нелинейной оптики. А затем решать их, что называется, «в лоб». Непосредственным моделированием — без всяких регистров и логических вентилей традиционных компьютеров, — получая готовый ответ в физическом виде. Но самое, быть может, захватывающее в данном подходе — это то, что и в квантовой физике давно известны (а также регулярно открываются новые) аналогии с физикой жидкостей. А это означает, что и здесь отчетливо обозначился маршрут к квантовому компьютеру существенно новой — оптической — конструкции... (Направление «метафорического компьютинга», стоит также отметить, начинали разрабатывать при финансовой поддержке DARPA, агентства передовых военных исследований министерства обороны США, затем из открытой области тему убрали, и в настоящее время в общедоступной научной печати развития данной технологии «как бы нет».)  Что же касается разработок в области биологии, где «классический» нановычислитель на основе сложных биомолекул типа ДНК пытаются конструировать с начала 1990-х годов, то и здесь наиболее заманчивые перспективы открываются на направлении, именуемом «квантовая биология» (подробности можно найти тут). Строго говоря, по мнению большинства физиков, такой вещи, как квантовая биология, не должно быть в принципе. Потому что «теплые и медленные» биологические процессы по самой природе своей не должны, казалось бы, демонстрировать квантовых эффектов. Однако они есть, и постепенно биофизики набирают все больше сильных фактов, это подтверждающих.  Ну а постижение механизмов квантовой биологии сулит ученым просто захватывающие перспективы — от освоения чрезвычайно эффективных технологий природы и вплоть до решения давних проблем науки. Выражаясь же чуть более конкретно, от передачи энергии без потерь и до тайн работы мозга. Вот лишь одна тому иллюстрация: на 2014-й финансовый год администрацией президента США Обамы предложен крупномасштабный, на 100 миллионов долларов, научный проект под названием BRAIN (Brain Research through Advancing Innovative Neurotechnologies — «исследование мозга продвинутыми новаторскими нейротехнологиями»). Цель проекта — создать компьютерную модель мозга как карту движения там информации в реальном масштабе времени, чтобы в итоге лучше представлять себе механизмы появления расстройств в работе мозга. Согласно предварительным подсчетам, для моделирования на суперкомпьютере клеток мозга в реальном времени требуется примерная производительность от 1 до 10 экзафлопс с 4 петабайтами памяти. Если говорить об этом в терминах потребления энергии, то даже по самым оптимистичным прогнозам подобная вычислительная система будет потреблять как минимум от 20 до 30 мегаватт. Стоит напомнить, что человеческий мозг потребляет примерно 20-40 ватт. Этот пример, для справки, взят также из доклада Хорста Саймона, одного из руководителей Национальной лаборатории им. Лоуренса в Беркли, известной, среди всего прочего, и как один из ведущих в мире центров по изучению квантовой биологии. ⇡#Точка критического перехода (вместо эпилога)Одна из недавних и очень важных научных работ, посвященных загадкам квантовой биологии, выдвигает и обосновывает интересную идею относительно того механизма, который препятствует процессу быстрой декогеренции в условиях горячей и влажной среды внутри живых существ (G. Vattay, S. Kauffman & S. Niiranen. "Quantum biology on the edge of quantum chaos". ArXiv:1202.6433). Иначе говоря, дается внятное объяснение тому, «почему квантовая биология реально работает». Расчеты показывают, что при определенных особых обстоятельствах квантовые системы могут оставаться когерентными на протяжении намного больших временных интервалов и расстояний, нежели это позволяют им традиционные квантовые представления. А кроме того, с помощью компьютерных симуляций продемонстрировано, что биологические системы, вероятно, используют именно этот специфический механизм в процессе фотосинтеза (демонстрирующего почти 100-процентную эффективность преобразования солнечной энергии в химическую).  Смоделированная учеными конструкция сфокусирована на довольно необычном физическом феномене, известном как «критический переход» между разными фазовыми состояниями. Пояснить этот феномен проще всего на примере поведения воды. Все знают, что вода меняет свое фазовое состояние от газа к жидкости, а затем к твердому телу при определенных температурах и давлениях среды. Причем все эти фазовые состояния имеют хорошо выраженные свойства. Однако имеется также такое сочетание температуры и давления, при котором все три состояния воды могут сосуществовать одновременно. При этом состоянии, именуемом «критический переход», различие между газом, жидкостью и твердым телом, по сути дела, исчезает, а система тонко балансирует между разными фазами. В новом же «квантово-биологическом» исследовании показано, что подобный критический переход появляется и тогда, когда квантовые системы переключаются в хаотический режим. Здесь исчезает различие между хаотическим поведением и обычным (линейным) квантовым поведением системы. И кроме того, в этих условиях квантовая когерентность неожиданно меняется от хрупкого и мимолетного режима к намного более устойчивому, надежному и долгоживущему феномену, получившему у авторов название Poised Realm, т. е. «подвешенная область». Именно в этом состоянии, считают авторы работы, должны происходить наблюдаемые в опытах процессы квантовой биологии. И что интересно, этот же самый критический переход известен также в физике твердого тела — как «переход металл — изолятор» (MIT), позволяющий с минимальными потерями транспортировать квантовую информацию и энергию в состоянии стабильной и длительной квантовой когерентности...  Иначе говоря, с помощью природы здесь нащупан единый и очень многообещающий механизм для создания надежных квантовых вычислителей — в потенциале способных работать при комнатных температурах на основе как биомолекулярной, так и твердотельной элементной базы (такие прогнозы вполне позволяют делать последние достижения науки в области топологических изоляторов и спинтроники). Скорее всего, суперкомпьютеры подобного рода будут не универсальными, а специализированными очень быстрыми вычислителями для определенного круга задач. Но удивительная ситуация в современной математике ныне такова, что ученым все чаще и чаще удается отыскивать явное и пока плохо объяснимое соответствие между разными математическими областями, которые прежде считались совершенно никак друг с другом не связанными. А переформулировка задач с языка одной области на язык другой позволяет очень эффективно решать такие проблемы, к которым раньше даже не знали как подступиться (подробности см. тут). Иначе говоря, вместе с развитием всей этой картины превращение специализированного компьютера в универсальный начинает выглядеть как сугубо техническая задача для квалифицированного программирования. Ну и к финалу еще один немаловажный нюанс. Чтобы наглядно проиллюстрировать темпы технического прогресса, нередко напоминают, что нынешний смартфон в кармане любого прохожего — это в смысле производительности компьютер, превосходящий самые передовые супервычислители фирмы Cray на рубеже 1970-1980 годов. То есть наивысшие достижения современного суперкомпьютинга завтра могут стать совершенно обычной бытовой техникой. И еще один прогноз можно выдвигать уже вполне определенно. Архитектура компьютеров следующей эпохи обещает оказаться намного более разнообразной. А значит, и более интересной. Как сама жизнь.

⇣ Содержание

Если Вы заметили ошибку — выделите ее мышью и нажмите CTRL+ENTER.

|